Die technischen Empfehlungen von Google für die Crawlbarkeit von AJAX-Seiten haben keine Gültigkeit mehr. Als Grund nennt das Unternehmen, dass man inzwischen in der Lage sei, Java Script auszuführen und zu verstehen. Webseitenbetreiber, die ihre Seiten nach den alten Vorgaben erstellt haben, müssen sich aber keine Sorgen machen.

Die technischen Empfehlungen von Google für die Crawlbarkeit von AJAX-Seiten haben keine Gültigkeit mehr. Als Grund nennt das Unternehmen, dass man inzwischen in der Lage sei, Java Script auszuführen und zu verstehen. Webseitenbetreiber, die ihre Seiten nach den alten Vorgaben erstellt haben, müssen sich aber keine Sorgen machen.

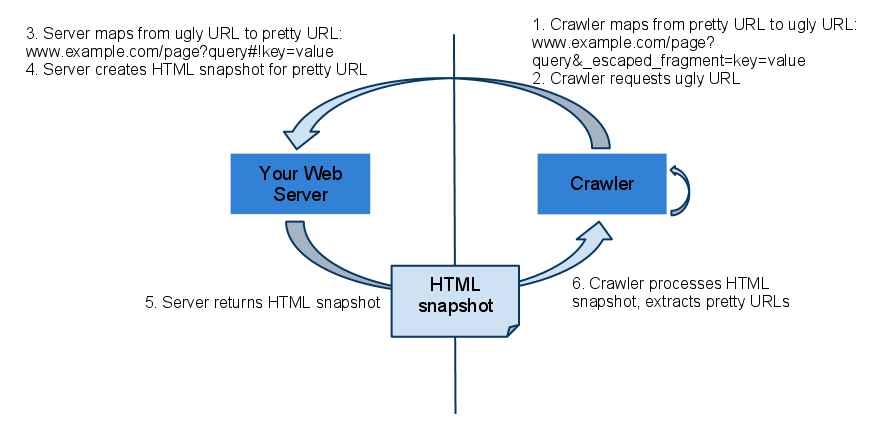

Das Crawlen und Indexieren von dynamischen Seiten, die auf AJAX basieren (Asynchronous Java Script and XML), bereitete Google und anderen Suchmaschinen lange Zeit Probleme, da die Inhalte der Seiten erst im Zuge des Aufrufs generiert werden. Für die Crawler war nur der auszuführende Java Script-Code sichtbar. Aus diesem Grund hatte Googe Empfehlungen abgegeben, wie solche Seiten aufzusetzen sind, damit auch deren Inhalte erfasst und indexiert werden können. Dazu gehört unter anderem das Ausliefern eines HTML-Snapshots der einzelnen Seiten, die unter einer eigenen URL zur Verfügung gestellt werden.

Ankündigung der Änderung bereits im März

Im März dieses Jahres hatte es dann Gerüchte gegeben, dass sich etwas an der Art und Weise ändern könnte, wie Google AJAX-Seiten auswertet. Einer der Gründe dafür war, dass Google inzwischen in der Lage ist, Java Script weitgehend zu interpretieren.

Vorsicht: CSS und Java Script nicht blockieren

Inzwischen ist aus diesen Gerüchten Gewissheit geworden. Wie Google schreibt, haben die Vorgaben für AJAX-Seiten keine Gültigkeit mehr. Solange Java Script- und CSS-Dateien nicht blockiert würden, könne Google AJAX-Webseiten wie moderne Browser rendern und verstehen. Zudem empfiehlt Google das Prinzip des Progressive Enhancement (schrittweise Verbesserung). Dabei handelt es sich um eine Strategie des Webdesigns, die auf semantisches HTML-Markup und externe Stylesheet- und Scripting-Technologien sowie auf Accessibility setzt.

Google beruhigt auch Webseitenbetreiber, die ihre Seiten auf Basis der alten Empfehlungen für AJAX erstellt haben. Solange die Indexeirung funktioniere, brauche man nichts zu ändern. Für neue Seiten empfiehlt Google jedoch das Vermeiden der _escaped_fragment_URLs. Statt dieser würde Google zukünftig die #!-URLs crawlen, rendern und indexieren.

Titelbild © AKS - Fotolia.com