Google arbeitet an neuen Richtlinien für die Crawlbarkeit von JavaScript. Damit könnte die aktuell herrschende Unsicherheit für AJAX-Webseiten beendet werden.

Google arbeitet an neuen Richtlinien für die Crawlbarkeit von JavaScript. Damit könnte die aktuell herrschende Unsicherheit für AJAX-Webseiten beendet werden.

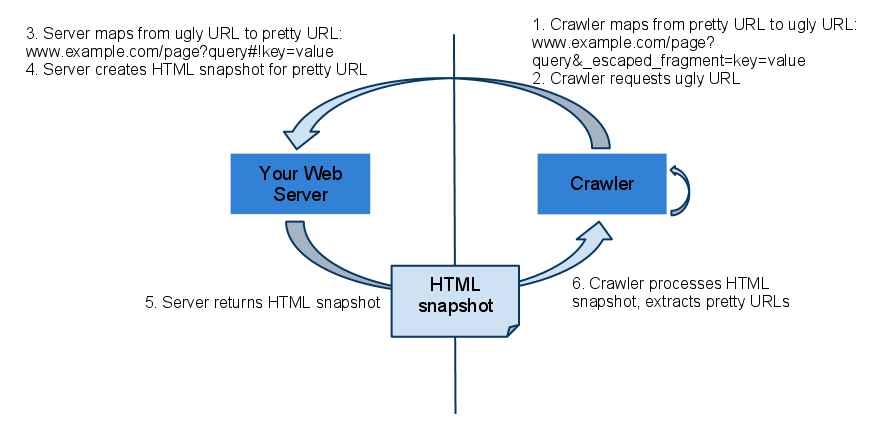

Das Crawlen und die Indexierung von dynamischen, JavaScript-basierten Webseiten (AJAX-Technologie) war lange Zeit für Google und andere Suchmaschinen problematisch. Die Crawler konnten das JavaScript entweder gar nicht oder nur zum Teil ausführen und interpretieren. Aus diesem Grund hatte Google Richtlinien für AJAX-Webseiten herausgegeben, die vorsehen, dass die Inhalte auch als statischer Snapshot zur Verfügung gestellt werden sollen. Der Crawler erhält also eine speziell für ihn bereitgestellte Version der Inhalte:

Nach und nach hat Google jedoch seine JavaScript-Fähigkeiten erweitert, so dass die Crawler inzwischen die meisten JavaScripte verstehen und ausführen können. Doch was bedeutet das für die Gestaltung von Webseiten? Derzeit kursieren Empfehlungen, die sich vor allem auf das "Progressive Enhancement" beziehen - das bedeutet, eine Webseite soll je nach Fähigkeiten des Clientes mehr oder weniger Features anbieten. Die Grundinhalte sollen auch für Clients mit Basisfähigkeiten verfügbar sein.

Um die Frage der Crawlbarkeit endgültig zu beantworten, will Google demnächst neue Richtlinien herausgeben. Laut Johannes Müller soll das noch in diesem oder im nächsten Monat geschehen. Außerdem sollen die Fähigkeiten zum Crawlen von JavaScript weiter verbessert werden. Das hat er im letzten englischsprachigen Webmaster-Hangout bestätigt:

Für die wachsende Zahl von AJAX-Webseiten wird dadurch hoffentlich die aktuell unsichere Situation in Bezug auf Crawlbarkeit und Indexierbarkeit aufgelöst.

Titelbild © makc76 - Fotolia.com