Wenn das JavaScript von Anzeigen auf einer Webseite aufgrund der robots.txt von Google nicht abgerufen werden kann, ist das kein Problem.

Wenn das JavaScript von Anzeigen auf einer Webseite aufgrund der robots.txt von Google nicht abgerufen werden kann, ist das kein Problem.

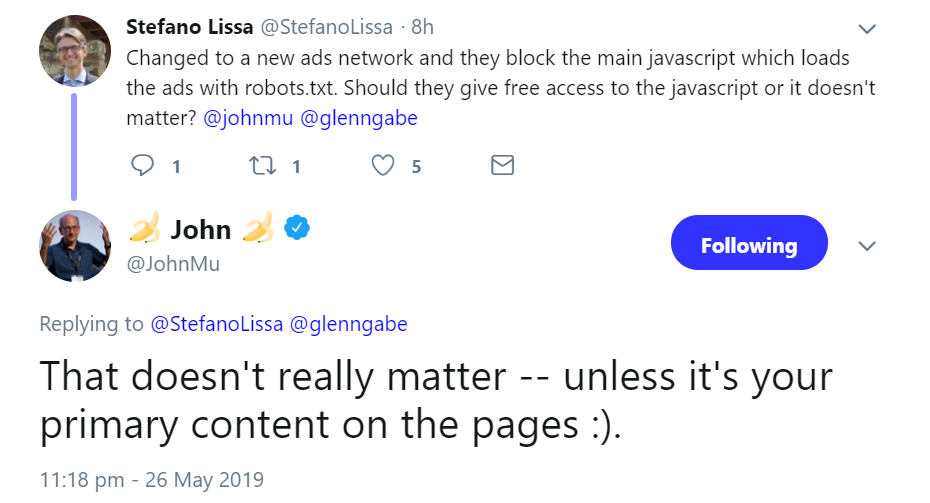

Google weist immer wieder darauf hin, dass Ressourcen, die zur Darstellung einer Webseite benötigt werden, nicht per robots.txt blockiert sein sollten. Das bezieht sich jedoch nicht auf Anzeigen auf einer Webseite. Darauf wies Johannes Müller per Twitter hin. Zuvor hatte ein Nutzer geschrieben, er habe das Werbenetzwerk gewechselt, und im neuen Netzwerk sei das JavaScript per robots.txt gesperrt.

Müller schrieb, das sei in Ordnung, solange es sich nicht um die Hauptinhalte der Webseite handele.

Um zu prüfen, ob wichtige Ressourcen einer Webseite für das Crawlen blockiert sind, kann man verschiedene Google-Tools verwenden, so zum Beispiel den Test auf Mobilfreundlichkeit, das URL Inspection Tool in der neuen Google Search Console sowie den robots.txt-Tester in der alten Search Console.

Titelbild: Copyright Patrick Daxenbichler - Fotolia.com