Google setzt sich dafür ein, dass das Robot Exclusion Protocol (REP) zum Internet-Standard wird. Damit soll sichergestellt werden, dass die Direktiven in den robots.txt-Dateien von den Crawlern lesbar sind und beachtet werden können. Gleichzeitig hat Google seinen Parser für robots.txt-Dateien als Open Source zur Verfügung gestellt.

Google setzt sich dafür ein, dass das Robot Exclusion Protocol (REP) zum Internet-Standard wird. Damit soll sichergestellt werden, dass die Direktiven in den robots.txt-Dateien von den Crawlern lesbar sind und beachtet werden können. Gleichzeitig hat Google seinen Parser für robots.txt-Dateien als Open Source zur Verfügung gestellt.

Auf den meisten Websites gibt es eine robots.txt-Datei. Darin wird geregelt, welche Crawler auf bestimmte URLs und Verzeichnisse zugreifen dürfen, und für welche URLs und Verzeichnisse der Zugriff gesperrt ist.

Damit die Crawler eine robots.txt richtig verstehen, müssen die darin enthaltenen Angaben syntaktisch korrekt sein. Zu diesem Zweck gibt es das Robot Exclusion Protocol (REP). Der Vorläufer dieses Protokolls wurde 1994 von Martijn Koster veröffentlicht und nach und nach zum REP weiterentwickelt. Allerdings hat sich das REP bis heute als offizieller Internet-Standard durchsetzen können. So kam es, dass verschiedene Varianten existieren und es für die Betreiber von Websites schwierig ist, die Direktiven in der robots.txt richtig zu formulieren.

Um dies zu vereinheitlichen, setzt sich Google jetzt dafür ein, das REP zu einem Internet-Standard zu machen. Wie Google in einem Blogpost schreibt, habe man gemeinsam mit dem ursprünglichen Autor, Webmastern und anderen Suchmaschinen dokumentiert, wie das REP im modernen Web genutzt wird, und dies an die IETF gesandt.

Bestehende Regeln sollen dadurch nicht geändert werden. Vielmehr gehe es darum, bisher nicht definierte Szenarien für das Parsen und Abgleichen von robots.txt-Dateien zu klären und eine Erweiterung für das moderne Web zu schaffen. Wichtig sind die folgenden Punkte:

- Jedes Übertragungsprotokoll, das auf URIs (Uniform Resource Identifiern) basiert, kann eine robots.txt verwenden. Dazu gehört nicht nur HTTP, sondern zum Beispiel auch FTP oder CoAP.

- Entwickler müssen mindestens 500 Kilobytes einer robots.txt parsen. Das Festlegen einer Obergrenze sorgt dafür, dass Verbindungen nicht zu lange offen bleiben und dass Server nicht zu sehr belastet werden.

- Eine neue maximale Obegrenze für das Caching von 24 Stunden gibt Webseitenbetreibern die Möglichkeit, ihre robots.txt flexibel anzupassen. Gleichzeitig überfordern Crawler die Websites nicht mit Anfragen an die robots.txt.

- Wenn eine zuvor verfügbare robots.txt auf einmal nicht mehr abgerufen werden kann, werden Seiten, die zuvor "disallowed" waren, für einen angemessenen Zeitraum weiterhin nicht gecrawlt.

Google stellt Parser für robots.txt als Open Source zur Verfügung

Webmaster und Entwickler, die Googles Parser für robots.txt-Dateien für eigene Anwendungen nutzen möchten, können jetzt auf die entsprechende C++ Bibliothek zugreifen, die Google in GitHub zur Verfügung gestellt hat. Wie Google schreibt, stammt der Code zum Teil aus den 90ern und wurde nach und nach erweitert, um Randfälle abdecken zu können, auf die man mit der Zeit gestoßen ist.

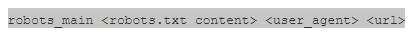

Enthalten ist auch ein Tool zum Testen des Parsers. Mit der folgenden Anweisung kann man eine Regel testen:

Mit der Standardisierung des REP wird es hoffentlich zukünftig etwas einfacher werden, robots.txt-Dateien so zu erstellen, dass sie den gewünschten Zweck erfüllen, ohne dabei unerwünschte Nebeneffekte zu erzielen.