Für Google ist die robots.txt eine URL wie andere auch. Sie kann genauso indexiert werden. Für das Crawlen gibt es aber eine Sonderstellung.

Für Google ist die robots.txt eine URL wie andere auch. Sie kann genauso indexiert werden. Für das Crawlen gibt es aber eine Sonderstellung.

Die robots.txt hat für Websites eine besondere Bedeutung, denn in ihr ist festgelegt, welche URLs und Verzeichnisse von den verschiedenen Suchmaschinen gecrawlt werden dürfen und welche nicht.

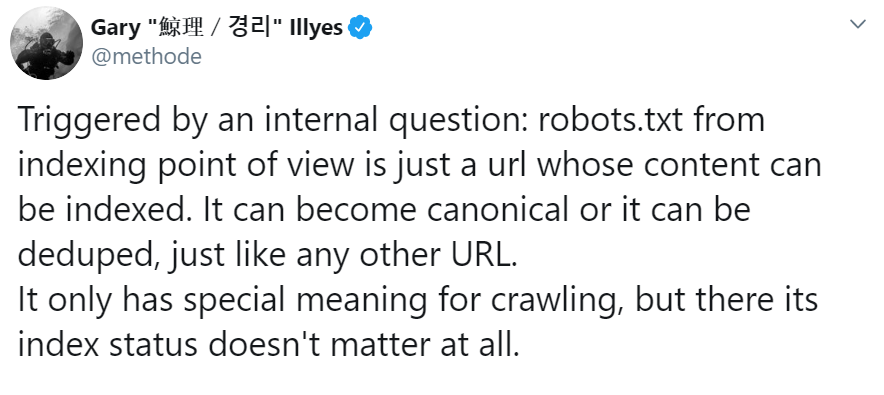

Google behandelt die robots.txt wie andere URLs einer Website. Das schrieb Gary Illyes auf Twitter. Auch die robots.txt könne indexiert werden, es sei möglich, dass sie als Canonical-URL ausgewählt werde und dass Dubletten entfernt würden. Für das Crawlen habe die robots.txt eine Sonderstellung. Dabei spiele der Indexierungsstatus keine Rolle:

Das bedeutet: Egal, ob Google die robots.txt indexieren kann oder nicht - die Datei wird von Google berücksichtigt. Voraussetzung dafür ist aber, dass die robots.txt auch abgerufen werden kann. Wie in dieser Woche berichtet können dauerhafte Probleme beim Abrufen der robots.txt zur Beeinträchtigung des Crawlens und sogar zum Deindexieren einer Website führen.

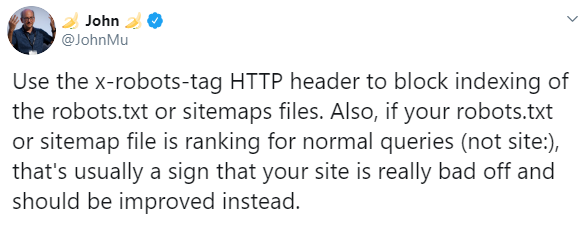

Update: Johannes Müller empfiehlt, das Indexieren der robots.txt per X-Robots-Header zu verhindern. Wenn die robots.txt für normale Suchanfragen in den Suchergebnissen erscheine (keine Site-Abfragen), dann sei das ein Zeichen, dass auf der Website etwas nicht stimme:

Interessant ist damit auch, dass grundsätzlich Inhalte der robots.txt in den Suchergebnissen erscheinen können. Ähnliches war auch schon für XML-Sitemaps bekannt geworden, weshalb zu empfehlen ist, diese auf "noindex" zu setzen.