Common Crawl, Harmonic Centrality und ihre Bedeutung für KI-Sichtbarkeit

Die Konzentration auf den PageRank (PR) war gestern, denn eine neue Kennzahl gewinnt derzeit für SEOs an Bedeutung. Die Rede ist von der Harmonic Centrality (HC). Sie weist Ähnlichkeiten mit dem PR auf, hat aber einen anderen Ursprung.

Während SEOs traditionell die klassischen Suchergebnisse von Google im Blick hatten, geht es nun zunehmend um die Datenquellen großer Sprachmodelle (LLMs). Eine zentrale Rolle spielt dabei Common Crawl. Es handelt sich dabei um eine Organisation, die Millionen von Websites crawlt. Die gesammelten Daten fließen in das Training von KIs ein.

Den möglichen Zusammenhang zwischen den archivierten Domains, der HC und den Citations in der KI hat jetzt Common Crawl selbst in einem Blogbeitrag beschrieben.

TL;DR: das Wichtigste in Kürze

- KI-Plattformen wie ChatGPT nutzen Common Crawl zum Trainieren ihrer Modelle.

- Websites, die in den Archiven von Common Crawl häufiger vorkommen, verbessern wahrscheinlich ihre Chancen auf KI-Erwähnungen (Citations).

- Domains mit einer höheren Harmonic Centrality (HC) haben eine größere Chance auf Archivierung durch Common Crawl.

- Das sollte auch beim Linkaufbau berücksichtigt werden: Zu bevorzugen sind Links mit hoher HC, die sich in der Nähe zentraler Websites befinden.

Common Crawl und der WebGraph

Common Crawl ist ein seit 2008 bestehendes Non-Profit-Projekt, welches das Internet in großem Maßstab archiviert und diese Daten als Open Source zur Verfügung stellt. Die Archive umfassen Petabytes an Daten und Milliarden von Webseiten.

Eine von der Mozilla Foundation veröffentlichte Analyse zeigt für den Zeitraum 2019 bis 2023, dass etwa 64 Prozent der 47 untersuchten großen Sprachmodelle Versionen von Common Crawl nutzen, wobei zum Beispiel bei GPT-3 über 80 Prozent der Trainingstokens aus gefilterten Common-Crawl-Daten stammten.

Um diese großen Datenmengen zu strukturieren, veröffentlicht Common Crawl monatlich neben den eigentlichen Seitenarchiven auch den sogenannten WebGraph. Dieser Datensatz liefert Analysen über die Verlinkungsstruktur von Milliarden von Seiten. Der WebGraph stellt Autoritätsmetriken bereit, die nicht nur für SEOs zur Analyse dienen, sondern vor allem den Crawler von Common Crawl (CCBot) selbst steuern. Der Crawler nutzt diese Metriken, um zu entscheiden, welche Domains priorisiert besucht werden.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

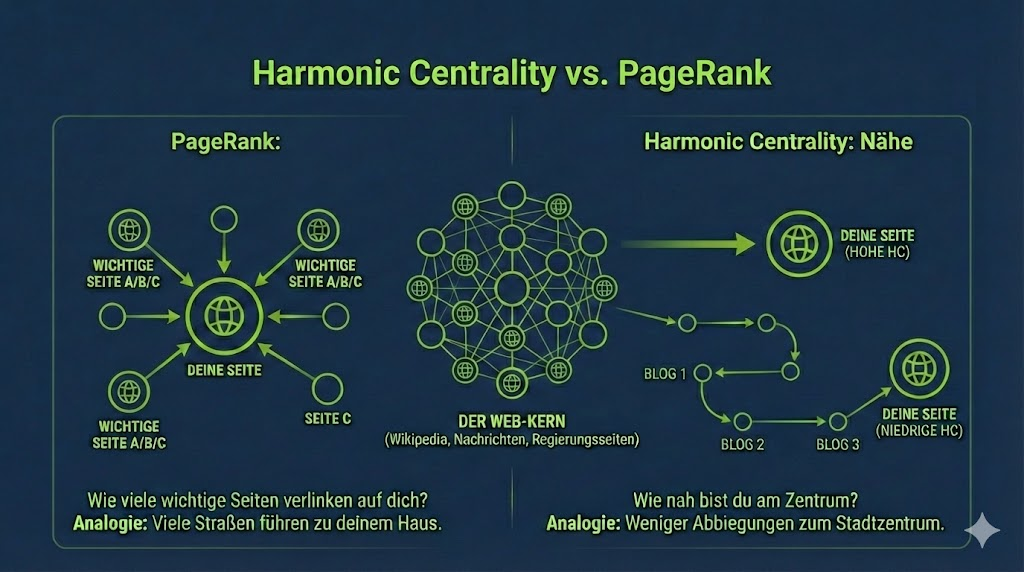

Harmonic Centrality vs. PageRank

Innerhalb des WebGraphs werden zwei zentrale Metriken unterschieden, die oft verwechselt werden, aber unterschiedliche Aspekte der Autorität beleuchten: Harmonic Centrality (HC) und PageRank (PR).

|

Metrik |

Was sie misst |

Bedeutung für Common Crawl |

|

Harmonic Centrality (HC) |

Misst, wie nahe eine Domain an allen anderen Domains im Graphen ist (Topologie). |

Dient als primäres Signal für die Crawl-Priorität des CCBots. |

|

PageRank (PR) |

Misst die Autorität basierend auf Qualität und Quantität eingehender Links. |

Dient als klassisches Maß für Link-Autorität und Popularität. |

Während der PR traditionell die Qualität der eingehenden Links und damit auch der verlinkten Websites bewertet, identifiziert die HC zentrale Knotenpunkte im Netz. Eine Domain mit hoher HC kann viele andere Domains über wenige Link-Sprünge erreichen bzw. ist über eine kurze Distanz mit wichtigen, autoritativen Websites verbunden.

Harmonic Centrality vs. PageRank: erstellt mit Google Nano Banana pro, basierend auf einer Grafik des Common Crawl Projects

Das beeinflusst auch die Prioritäten beim Linkaufbau. Wie Hanns Kronenberg auf LinkedIn schreibt, bringen zum Beispiel gekaufte Links in peripheren Netzwerken für die HC wenig, weil deren Distanz zum Kern des Webs groß ist. Statt vieler Links mit geringer HC sollten weniger Links mit geringer HC aufgebaut werden.

Common Crawl nutzt die Harmonic Centrality, um die Crawl-Priorität festzulegen. Webseiten mit einem hohen HC-Wert werden häufiger gecrawlt, was zu mehr Einträgen in den monatlichen Archiven von Common Crawl führt. Eine stärkere Präsenz in den Archiven erhöht wiederum die Wahrscheinlichkeit, signifikant in den Trainingsdaten der KI-Modelle vertreten zu sein.

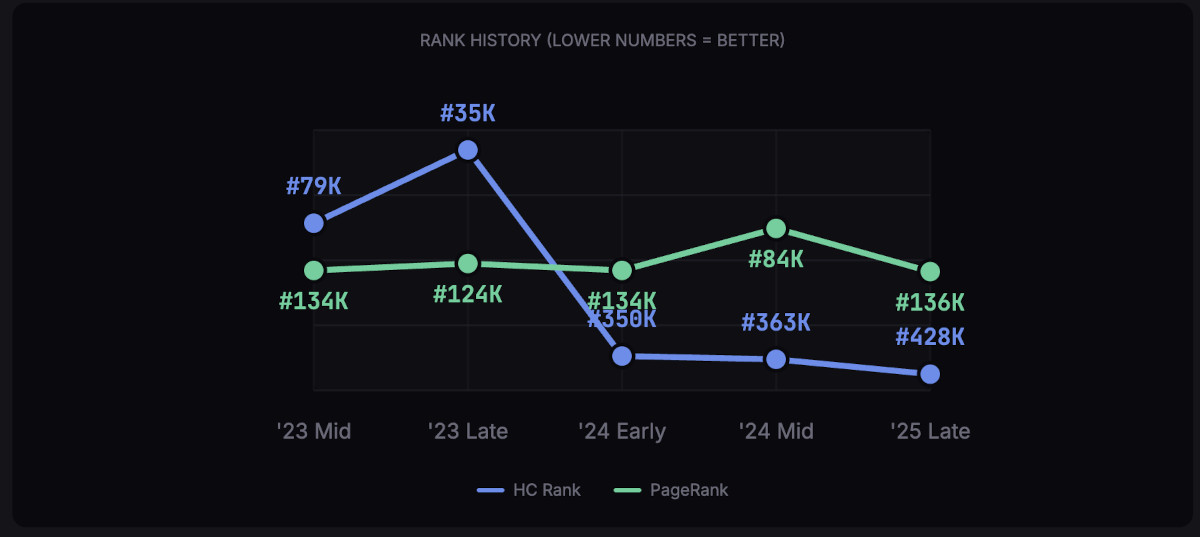

Tipp: Mit dem CC Rank Checker von Metehan Yesilyurt lassen sich PR und HC von Domains prüfen und vergleichen.

Ergebnis des CC Rank Checkers: Beispiel

Korrelation vs. Kausalität: Warum werden Domains zitiert?

Wie SEO Metehan Yesilyurt untersucht hat, zeigen die analysierten Daten eine deutliche Korrelation: Domains, die im WebGraph sehr hoch ranken, wie Facebook, Google, YouTube oder Wikipedia, gehören auch zu den am häufigsten von LLMs zitierten Quellen. Dabei muss jedoch differenziert zwischen Korrelation und Kausalität unterschieden werden. Die Frage lautet: Werden diese Websites zitiert, weil sie überproportional in den Trainingsdaten vertreten sind, oder sind sie in den Trainingsdaten präsent und werden zitiert, weil sie ohnehin autoritäre Quellen sind?

Vermutlich geht es um eine Mischung aus beidem. Eine hohe Präsenz in den Trainingsdaten schafft eine Grundvertrautheit ("Baseline Familiarity") des Modells mit der Quelle. Wenn Common Crawl aufgrund hoher HC eine Domain bevorzugt crawlt, lernt das Modell diese Quelle intensiver kennen. Gleichzeitig zeigen Studien wie die von Brie Mureau, dass auch traditionelle Google-Rankings stark mit der Zitierwahrscheinlichkeit in KIs korrelieren: Eine Seite auf Position eins bei Google hat eine fast 50-prozentige Wahrscheinlichkeit, von einer KI zitiert zu werden, während diese auf Position zehn auf etwa 20 Prozent sinkt. Die Autorität einer Seite ist also der primäre Treiber, aber die technische Verfügbarkeit im Trainingsdatensatz durch hohe HC-Werte wirkt als Verstärker.

Jenseits der Trainingsdaten: Weitere Einflussfaktoren

Die Präsenz im Common Crawl Datensatz deckt primär das Weltwissen des Modells (on-model) ab, doch für aktuelle Anfragen nutzen KI-Plattformen wie ChatGPT oder Perplexity Live-Retrieval-Systeme (RAG, off-model). Hierbei spielen Faktoren eine Rolle, die über die reine Trainingshistorie hinausgehen. Insbesondere die Aktualität (Freshness) und das Content-Format sind ausschlaggebend.

Verschiedene Untersuchungen zeigen, dass LLMs eine Vorliebe für vergleichende Inhalte haben: Listicles machen nach der Analyse von Mureau etwa 32,5 Prozent aller KI-Zitate aus, weil sie Informationen in einer für das Modell leicht zu verarbeitenden Struktur bieten. Zudem nutzen Systeme wie der Web-Modus von ChatGPT Verfahren wie Reciprocal Rank Fusion (RRF), um Ergebnisse aus verschiedenen Suchanfragen zu mischen. Seiten, die in mehreren Verfahren gute Rankings erzielen (Co-Citations), haben eine deutlich höhere Chance, in der finalen Antwort zitiert zu werden. Auch technische Aspekte wie Schema-Markup und schnelle Ladezeiten korrelieren positiv mit der Häufigkeit von Erwähnungen, da sie die Lesbarkeit für den Bot erleichtern.

Zusammengefasst haben diese Kriterien eine hohe Wahrscheinlichkeit, die Chance auf Citations in KI-Systemen zu erhöhen:

- Aktuelle Inhalte (Content Freshness und Recency)

- Semantische, also inhaltliche Relevanz zur Suchanfrage

- Strukturierte Daten und Formatierung

- Sichtbarkeit und Erwähnung der Marke auf verschiedenen Plattformen

- Häufigkeit,mit der eine Domain in den Trainingsdaten erscheint

- Autoritätssignale wie PageRank

- Zu den von einer spezifischen Plattform bevorzugten Inhalten gehören, also zum Beispiel Wikipedia bei ChatGPT oder Reddit bei Perplexity

Konkrete Folgerungen und Maßnahmen für SEOs

Für SEOs ergeben sich aus diesen Erkenntnissen einige Handlungsempfehlungen:

- Technisch ist sicherzustellen, dass der CCBot (der Crawler von Common Crawl) nicht per robots.txt blockiert wird.

- SEOs sollten die Harmonic Centrality (HC) ihrer Domain überwachen.

- Linkbuilding-Strategien anpassen: Statt nur auf das Volumen von Backlinks zu achten, zählt für die KI-Sichtbarkeit die Positionierung innerhalb der Link-Topologie – ein einzelner Link von einer zentral im Web verankerten Seite kann für die HC wertvoller sein als viele isolierte Links.

- Vergleichende Inhalte wie Listicles bieten gute Chancen. Hier sollte aber unbedingt auf Qualität geachtet werden (klassische SEO).

- Auf aktuelle Inhalte Wert legen und bestehende Beiträge auf den neuesten Stand bringen

SEO-Newsletter bestellen

Verwandte Beiträge

Google Search Console: keine Indexierungsdaten vor dem 15. Dezember