robots.txt: Google AdsBot nicht von 'Googlebot' abgedeckt

Vorsicht bei der Verwendung von 'Googlebot' in den Direktiven innerhalb der robots.txt: Damit ist nicht der Googlebot für Ads abgedeckt.

Vorsicht bei der Verwendung von 'Googlebot' in den Direktiven innerhalb der robots.txt: Damit ist nicht der Googlebot für Ads abgedeckt.

Innerhalb der robots.txt gibt es die Möglichkeit, Direktiven wie "disallow" nach verschiedenen User Agents aufzuteilen. Um beispielsweise bestimmte Seiten oder Verzeichnisse für den Googlebot freizugeben oder zu sperren, kann man den User Agent "Googlebot" verwenden wie im folgenden dargestellt:

User-agent: Googlebot

Disallow: /

Damit wäre die komplette Seite für den Googlebot gesperrt.

Nun ist es aber so, dass es nicht nur einen, sondern sehr viele verschiedene Googlebots gibt, etwa für Desktop und Mobile und auch für Google Ads.

Der Google AdsBot ist aber vom User Agent "Googlebot" nicht abgedeckt, sondern benötigt seine eigenen Direktiven. Das geht aus der zugehörigen Hilfeseite hervor.

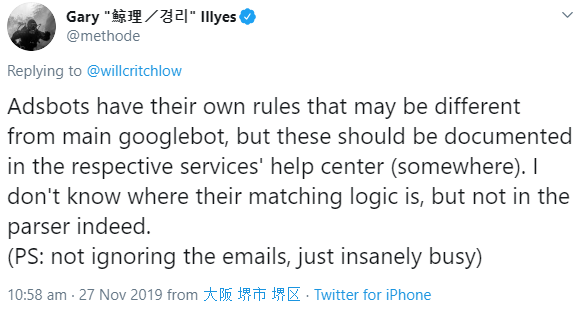

Dass eine solche Unterscheidung in der robots.txt offenbar notwendig ist, fiel SEO Will Critchlow auf, der dies auf Twitter postete und zugleich die Frage stellte, ob die Google AdsBots eigene Regeln verfolgen würden. Im Tool zum Testen der robots.txt hatte er gesehen, dass die untersuchte Seite trotz des Sperrens für "Googlebot" offenbar für den Google AdsBot freigegeben war:

Gary Illyes antwortete, die Regeln für AdsBots könnten sich von denen des Haupt-Googlebots unterscheiden. Dies sollte entsprechend dokumentiert sein.

Für alle diejenigen, die Direktiven für den Google AdsBot in die robots.txt aufnehmen möchten, bedeutet das, dass sie diesen jeweils gesondert behandeln müssen. Direktiven für den normalen Googlebot greifen hier nicht.

Titelbild: Copyright Patrick Daxenbichler - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

GPTBot auf Platz 3 der meistgenutzten Crawler, Google nach wie vor Nummer 1