Änderungen nicht gleich wirksam: Google hält robots.txt bis zu einem Tag im Cache

Änderungen an der robots.txt wirken sich nicht sofort in der Suche aus, denn Google hält die robots.txt bis zu einem Tag im Cache. Doch es gibt eine Möglichkeit, dies zu beschleunigen.

Änderungen an der robots.txt wirken sich nicht sofort in der Suche aus, denn Google hält die robots.txt bis zu einem Tag im Cache. Doch es gibt eine Möglichkeit, dies zu beschleunigen.

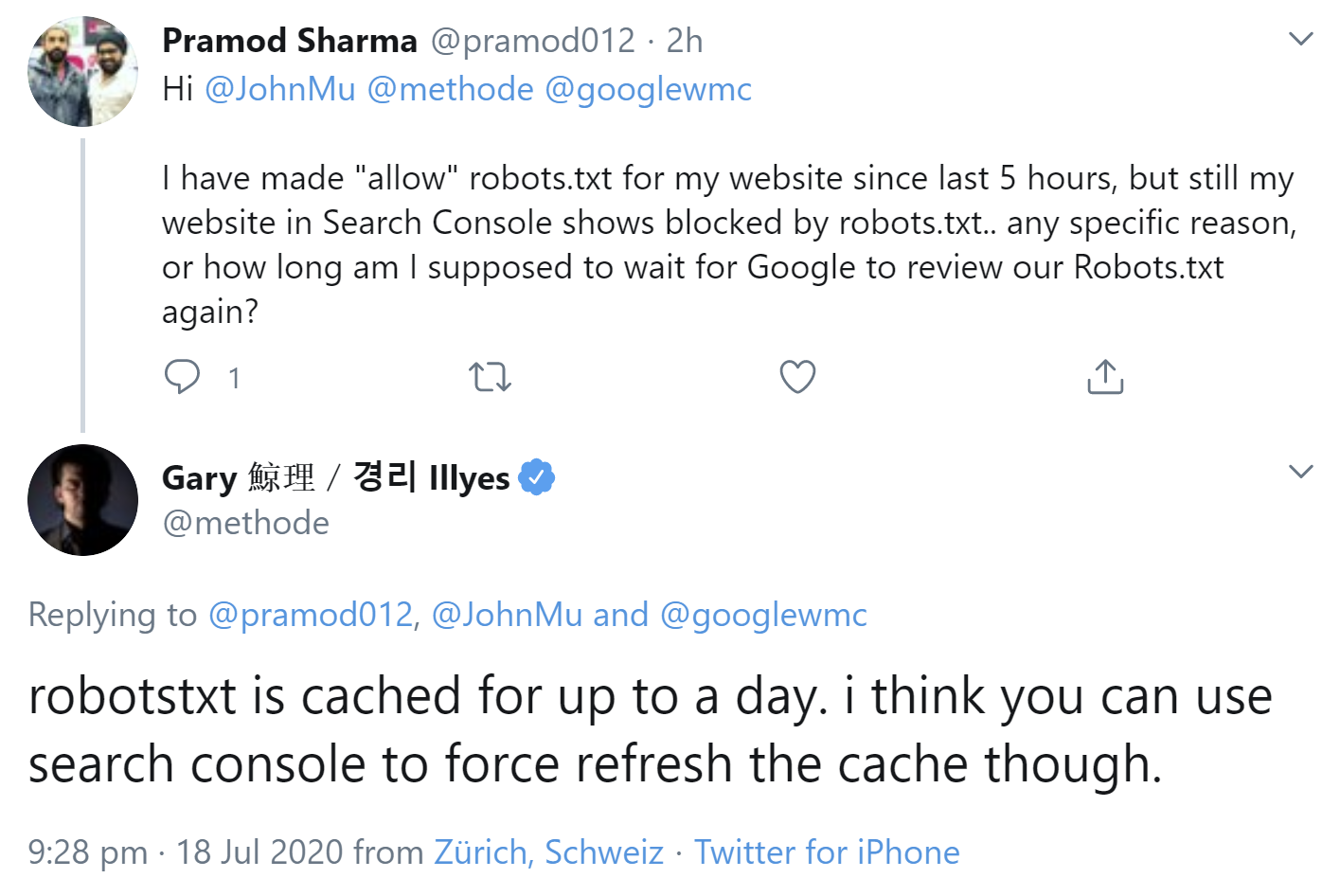

Wer Änderungen an der robots.txt seiner Website vornimmt, um zum Beispiel blockierte Seiten oder Ressourcen für Google freizugeben, muss damit rechnen, dass die Änderungen sich nicht sofort auswirken. Der Grund: Google hält die robots.txt bis zu einem Tag im Cache. Das erklärte Gary Illyes per Twitter. Er wies aber auch auf die Möglichkeit hin, dies zu beschleunigen und Google dazu zu bringen, den Cache zu aktualisieren. Dies kann per Google Search Console geschehen:

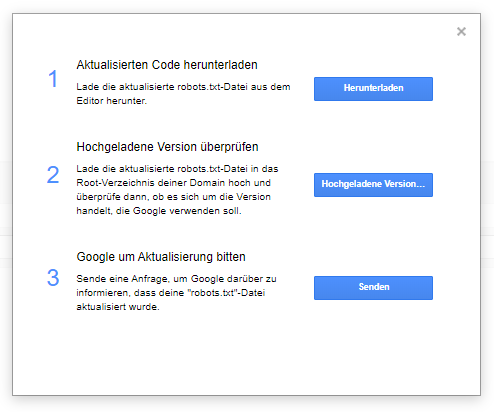

In der Google Search Console muss man dazu den robots.txt-Tester aufrufen, den es nur in der alten Version der Search Console gibt. Dort kann man auf "Senden" klicken und wird dann aufgefordert, die robots.txt zu ändern, sie auf den Server hochzuladen und Google danach zu informieren, damit die neue robots.txt abgerufen werden kann:

Auf diese Weise kann die Wartezeit bis zu den Wirkungen von Änderungen in der robots.txt verkürzt werden.

Titelbild: Copyright Patrick Daxenbichler - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

Google: URLs, die trotz robots.txt indexiert sind, fallen irgendwann aus dem Index