Per robots.txt gesperrt und dennoch indexiert: Google wertet solche Seiten nicht

Seiten bzw. URLs, die per robots.txt gesperrt und dennoch indexiert sind, werden von Google nicht zur Bewertung einer Website verwendet.

Seiten bzw. URLs, die per robots.txt gesperrt und dennoch indexiert sind, werden von Google nicht zur Bewertung einer Website verwendet.

Auch Seiten bzw. URLs, die per robots.txt gesperrt sind, können von Google indexiert werden. Die betreffenden URLs werden im Bericht zur Indexabdeckung in der Google Search Console aufgeführt.

Die Frage lautet, ob Google auch solche URLs zur Bewertung einer Website verwendet. Immerhin sind sie indexiert, wobei Google aufgrund der robots.txt keine Möglichkeit hat, die URLs zu crawlen und deren Inhalte zu ermitteln.

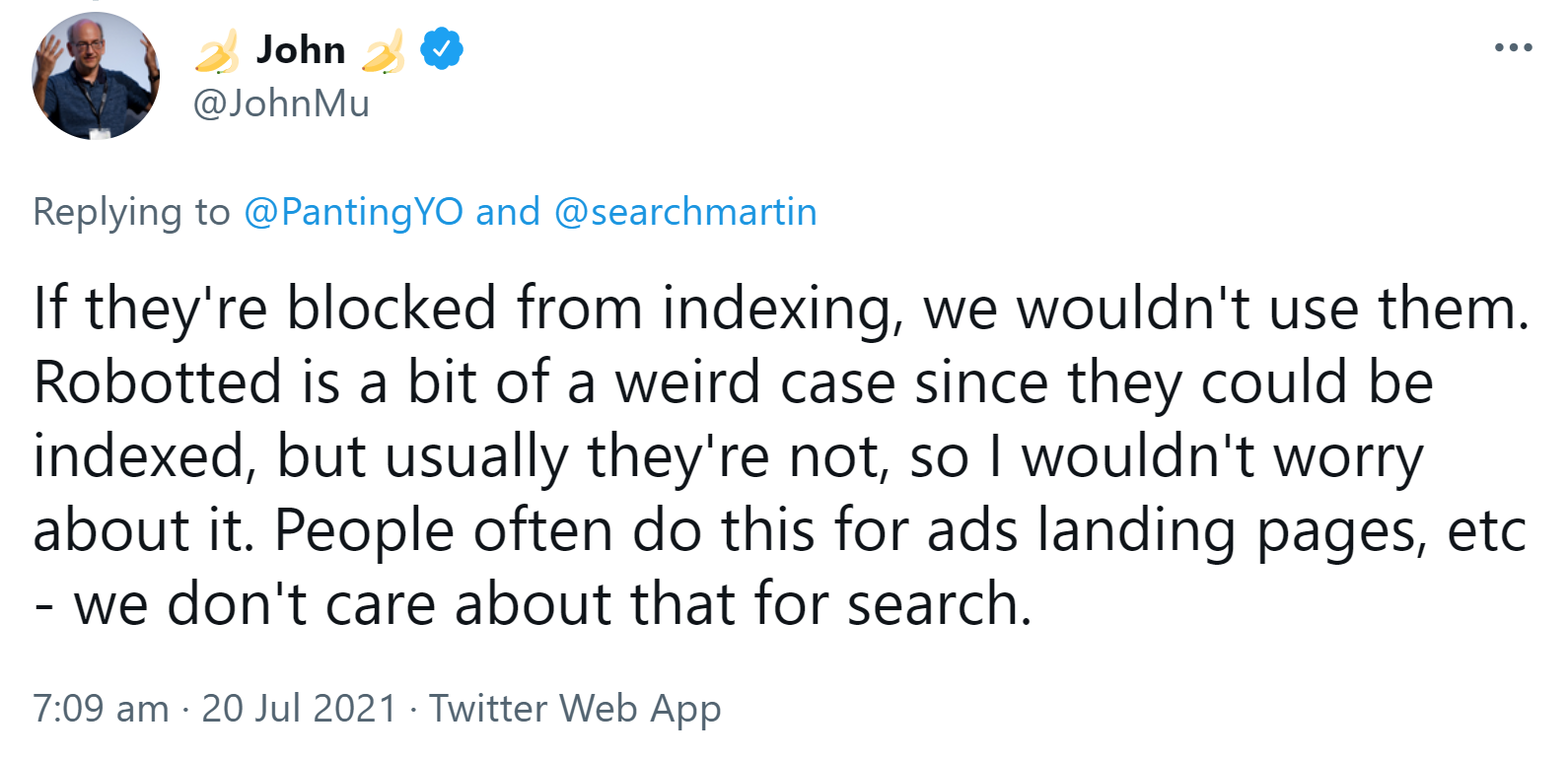

John Müller schrieb dazu, man solle sich deswegen keine Sorgen machen. Zwar sei die Sperrung per robots.txt ein Sonderfall. So etwas könne zum Beispiel bei Landing Pages für Ads passieren. Für die Suche spiele es aber keine Rolle:

"If they're blocked from indexing, we wouldn't use them. Robotted is a bit of a weird case since they could be indexed, but usually they're not, so I wouldn't worry about it. People often do this for ads landing pages, etc - we don't care about that for search."

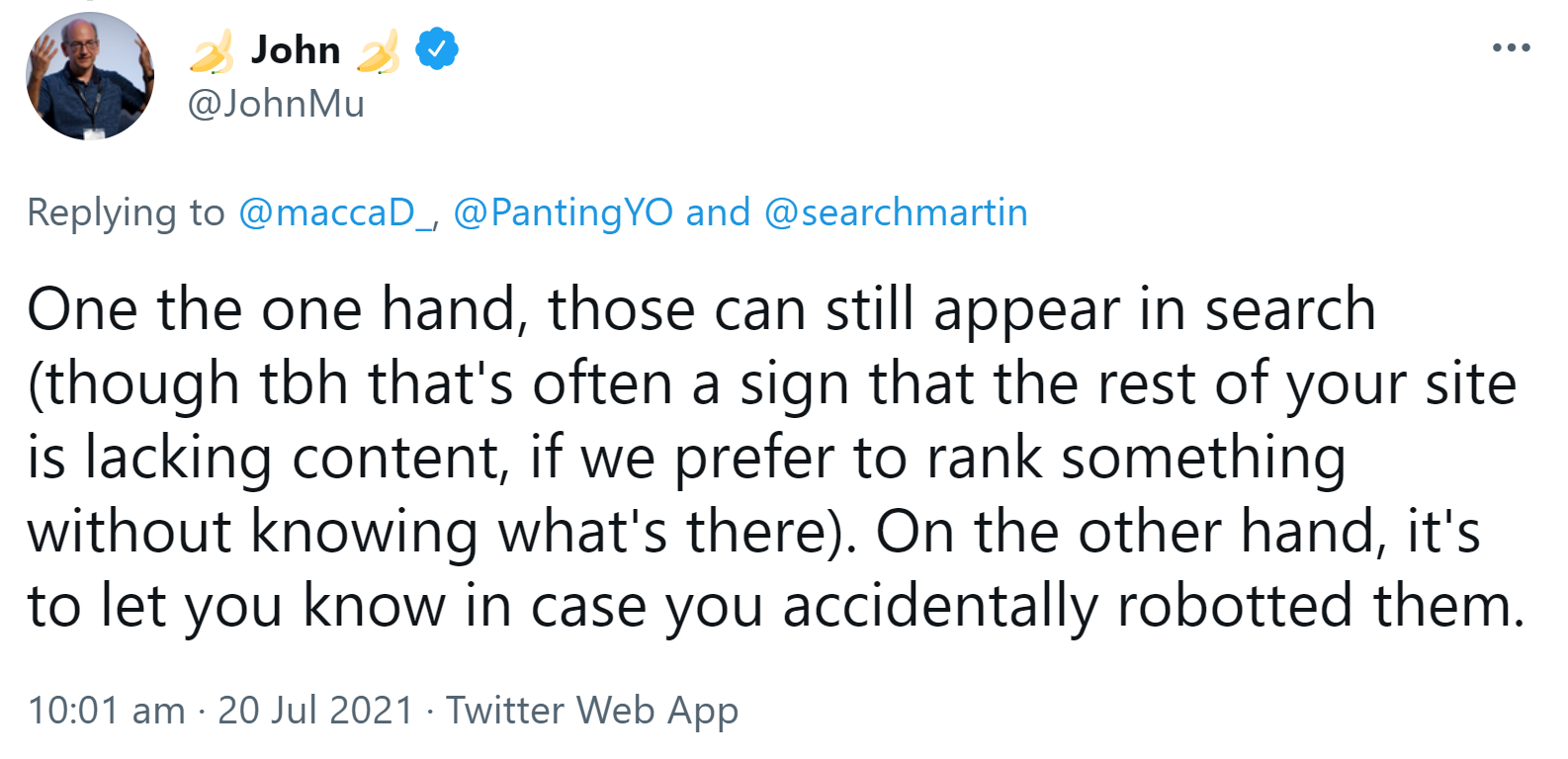

Warum erscheinen dann solche URLs überhaupt in der Google Search Console? Dazu schrieb Müller, erstens seien sie indexiert und können in der Suche erscheinen, und zweitens könne es auch passieren, dass man URLs aus Versehen per robots.txt sperre:

"One the one hand, those can still appear in search (though tbh that's often a sign that the rest of your site is lacking content, if we prefer to rank something without knowing what's there). On the other hand, it's to let you know in case you accidentally robotted them."

Es kann also nicht schaden, sich die URLs in der betreffenden Kategorie der Google Search Console anzusehen, um zu prüfen, ob sich darunter URLs befinden, die indexiert werden sollen. In diesem Fall dürfen sie nicht per robots.txt gesperrt sein.

Titelbild: Copyright Patrick Daxenbichler - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

Google: URLs, die trotz robots.txt indexiert sind, fallen irgendwann aus dem Index