Fluktuation bei der Indexierung? Dann geht es darum, Google zu überzeugen

Wenn neue Seiten nicht oder erst spät indexiert werden, muss man Google davon überzeugen, dass sich das Indexieren zusätzlicher Seiten lohnt. Beim Crawlen kommt es auf die Einbindung der Seiten an.

Wenn neue Seiten nicht oder erst spät indexiert werden, muss man Google davon überzeugen, dass sich das Indexieren zusätzlicher Seiten lohnt. Beim Crawlen kommt es auf die Einbindung der Seiten an.

Immer wieder wird von Websites berichtet, auf denen es Probleme mit der Indexierung gibt. Das kann sich zum Beispiel dadurch äußern, dass neue Seiten erst nach einigen Tagen indexiert werden, oder dass es notwendig ist, neue Seiten per URL Submission Tool einzureichen, damit sie ihren Weg in den Index finden.

So etwas hat meistens keine technischen Gründe, sondern Google sieht bei solchen Websites einfach keinen Bedarf, weitere Seiten zu indexieren. Denn normalerweise funktioniert das Crawlen und Indexieren neuer Seiten gerade bei kleinen und mittelgroßen Websites reibungslos. Ursachen wie ein zu knappes Crawl-Budget kommen meist nur bei sehr großen Websites in Betracht. Wie Google schon mehrfach erklärt hat, liegt ein Schlüssel bei Indexierungsproblemen in der Qualität der betreffenden Websites.

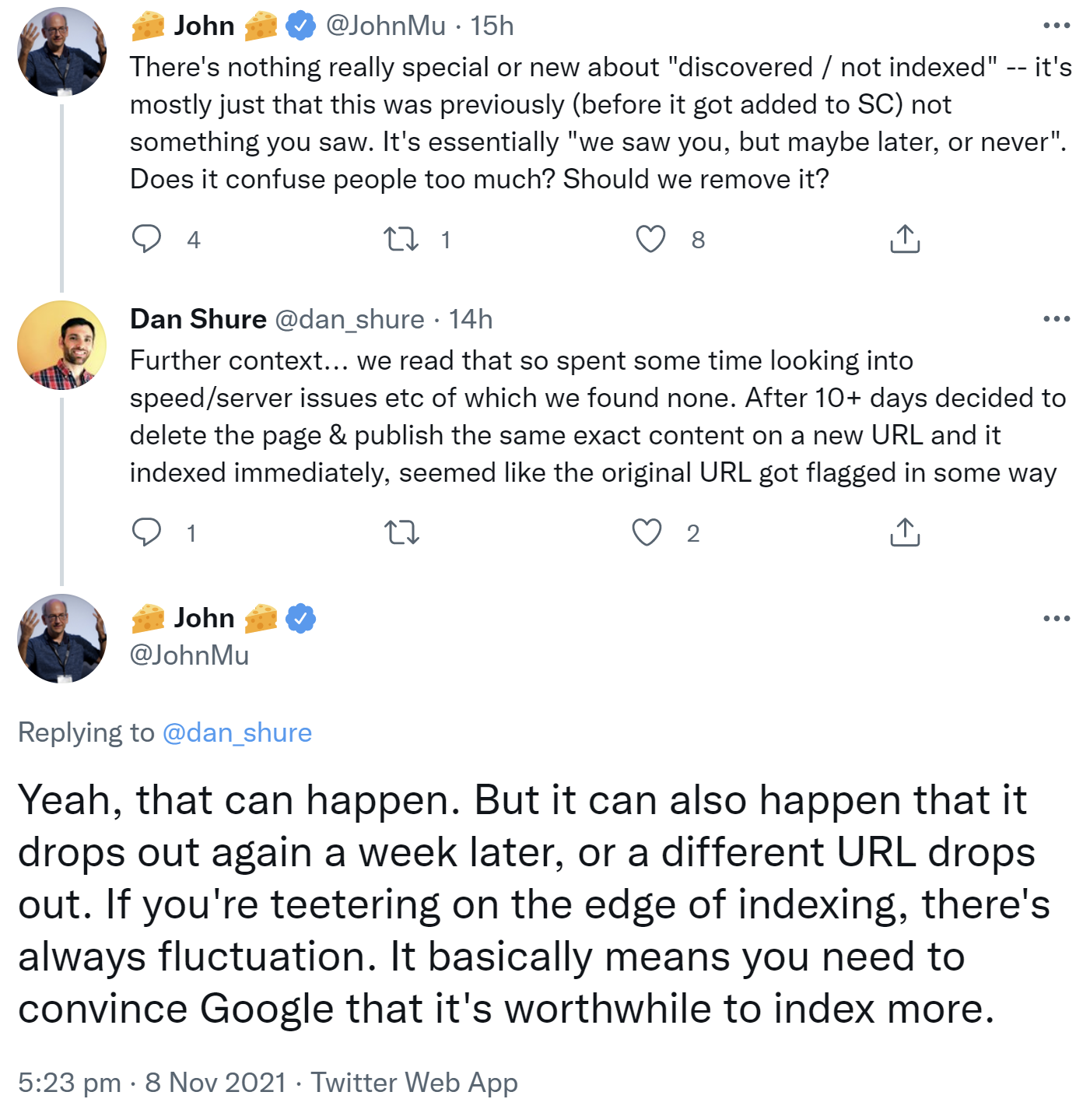

Dazu hat John Müller jetzt einen weiteren Hinweis gegeben: Schwankungen bei der Indexierung seien ein Zeichen dafür, dass man Google überzeugen müsse, weitere Seiten zu indexieren. Er antwortete dabei auf eine Serie von Tweets, in denen eine Website beschrieben wurde, bei der bestimmte URLs nicht indexiert wurden. Nach dem Wechsel der URL seien die neuen URLs dann tatsächlich im Index gelandet.

John Müller schrieb, so etwas könne passieren. Es könne aber auch sein, dass die URLs nach einer Woche wieder aus dem Index verschwinden, oder dass andere URLs entfernt werden. Wenn man Schwankungen im Grenzbereich der Indexierung erfahre, gebe es immer Fluktuation. Man müsse Google davon überzeugen, dass es sich lohne, mehr zu indexieren:

"Yeah, that can happen. But it can also happen that it drops out again a week later, or a different URL drops out. If you're teetering on the edge of indexing, there's always fluctuation. It basically means you need to convince Google that it's worthwhile to index more."

Doch wie kann man Google davon überzeugen, dass sich das Indexieren neuer Inhalte lohnt? John Müllers einfache Antwort darauf lautet: "Awesomeness", also Großartigkeit:

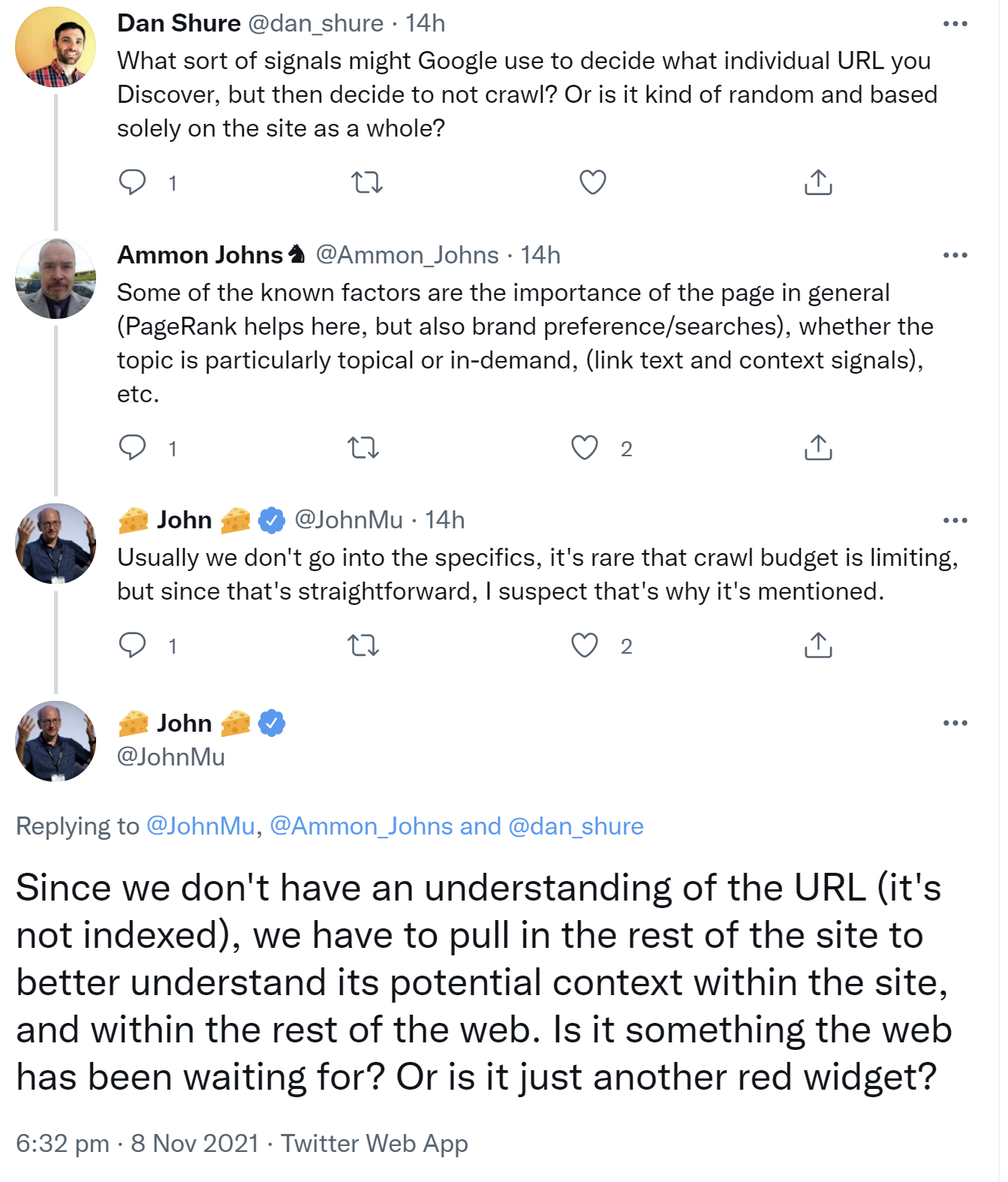

Wenn Google entscheiden muss, ob eine Seite gecrawlt wird oder nicht, spielt laut Müller die Einbindung der Seite in die gesamte Website und in das Web eine Rolle. Weil Google dies noch nicht aufgrund der Seite selbst entscheiden könne - diese sei ja nicht indexiert - müsse der Kontext bewertet werden. Ist es etwas, worauf das Web gewartet hat, oder handelt es sich einfach nur um ein neues rotes Widget?

"Since we don't have an understanding of the URL (it's not indexed), we have to pull in the rest of the site to better understand its potential context within the site, and within the rest of the web. Is it something the web has been waiting for? Or is it just another red widget?"

Ob Google Seiten crawlt und indexiert, wird also anhand verschiedener Kriterien entschieden. Neben den Inhalten und der Qualität, die für die Indexierung eine Rolle spielen, kommt auch die Einbindung der Seiten zur Anwendung. Hier dürfte es vor allem um interne und externe Links gehen.

Schwankungen bei der Indexierung sind aber normal. Ebenfalls normal ist es, dass Google nicht alle Seiten einer Website indexiert. Werden aber wichtige Seiten nicht indexiert, sollte die Qualität der Seiten geprüft und verbessert werden.

SEO-Newsletter bestellen

Verwandte Beiträge

Google folgt Links nicht direkt, sondern crawlt asynchron