Zahlreiche Websites blockieren ChatGPT bereits per robots.txt

Kurz nach der Bereitstellung einer Möglichkeit zum Aussperren von ChatGPT per robots.txt machen bereits einige Websites Gebrauch davon.

Wer nicht möchte, dass die Inhalte der eigenen Website in das Large Language Model von ChatGPT einfließen und damit in den Antworten des Chatbots landen können, kann ChatGPT per robots.txt aussperren.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

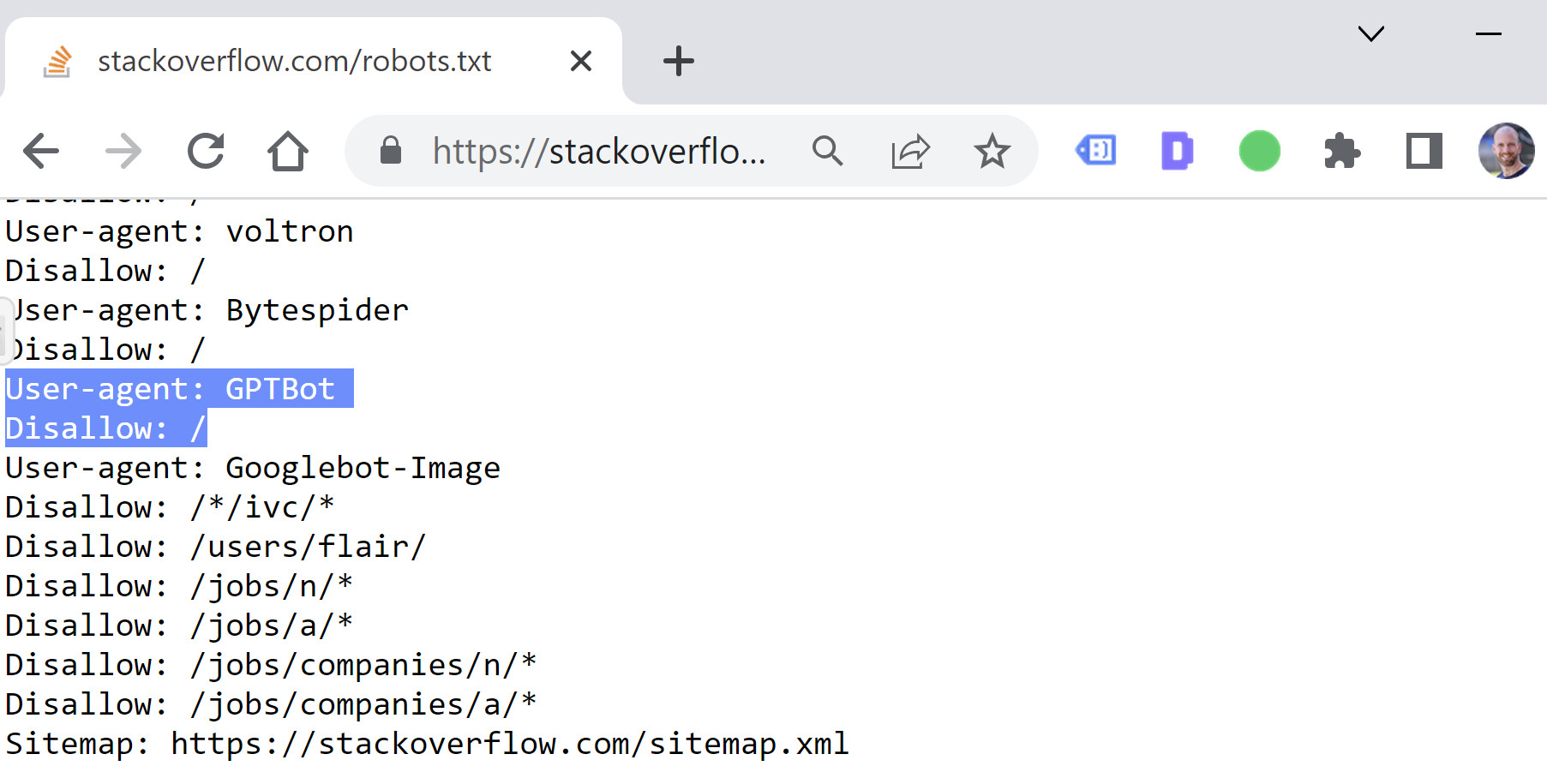

Dazu muss einfach dieser Eintrag in die robots.txt übernommen werden:

User-agent: GPTBot

Disallow: /

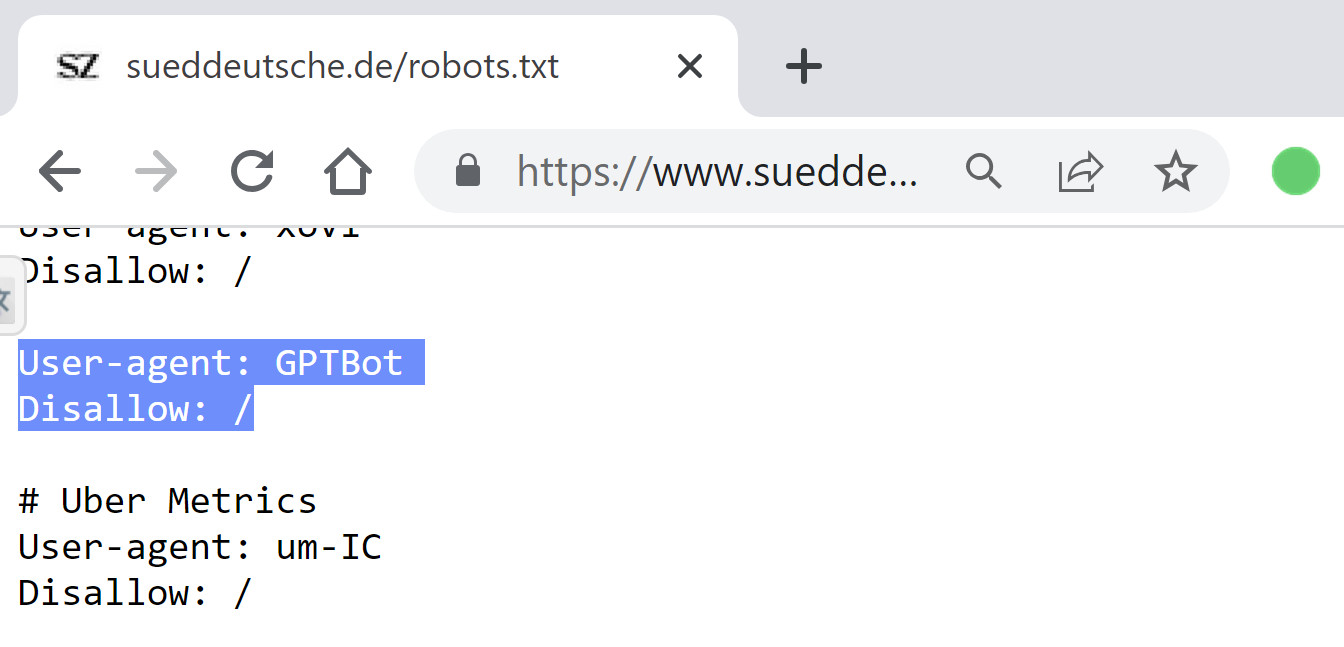

Inzwischen findet sich dieser Eintrag in der robots.txt schon auf verschiedenen Websites. Darunter befinden sich auf große Publikationen wie die Süddeutsche:

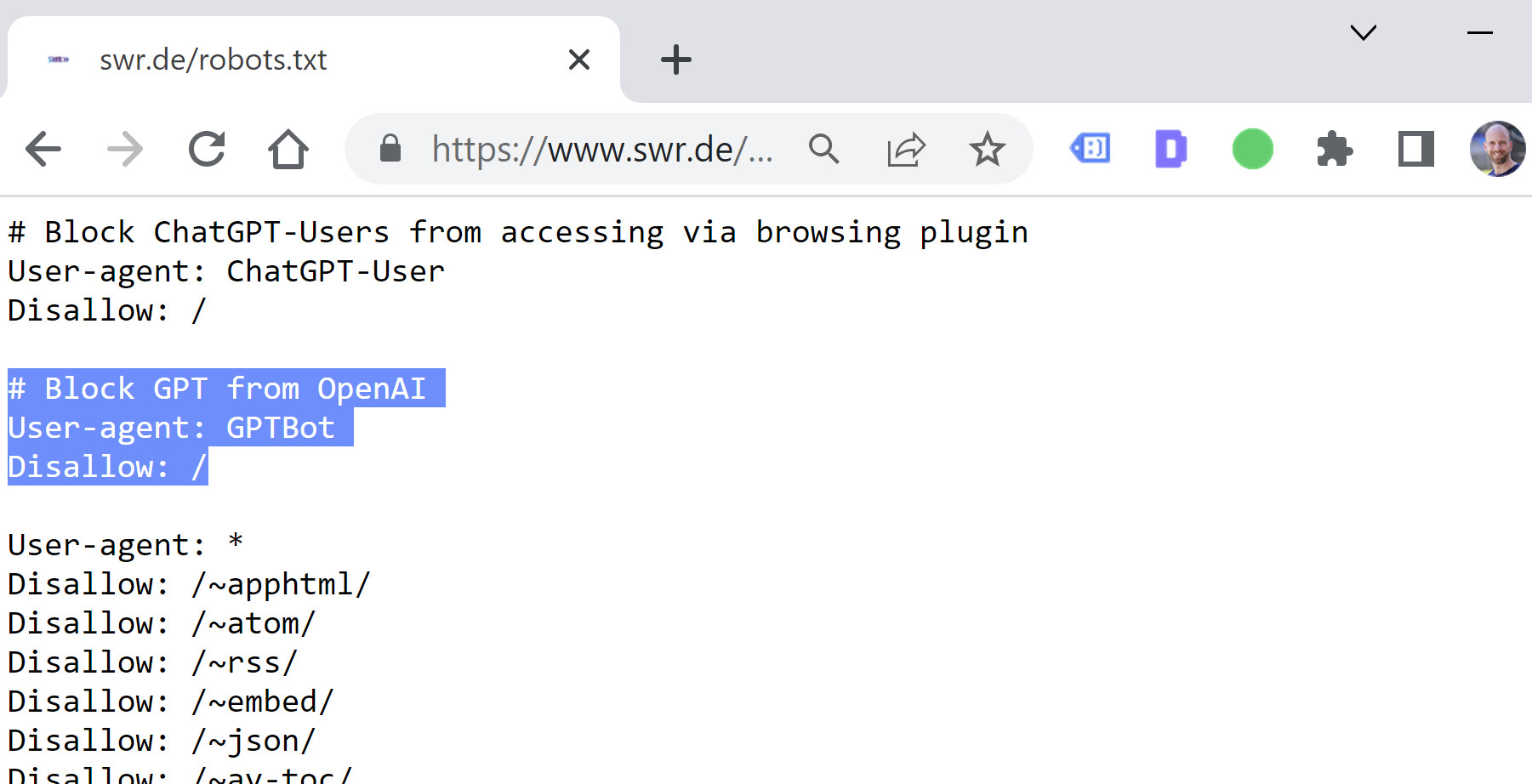

Und auch der SWR sperrt ChatGPT von seinen Seiten aus:

Internationale Websites nutzen ebenfalls die Möglichkeit zum Blockieren von ChatGPT. Zu ihnen gehört beispielsweise Stack Overflow (danke an dieser Stelle für den Hinweis an Juan González Villa):

Andere große Websites wie der Spiegel oder Focus haben dagegen noch keinen Eintrag zum Blockieren von ChatGPT in ihrer robots.txt.

Mit dem Aussperren von ChatGPT ist meist die Absicht verbunden, die eigenen Inhalte zu schützen, so dass sie nicht einfach vom Chatbot genutzt werden können, ohne dass die Website dafür Traffic erhält. Ohnehin ist die Verwendung von gecrawlten Inhalten zum Trainieren von Large Language Models ohne entsprechende Kompensation für die Urheber ein Thema, das vermutlich noch rechtlicher Klärung bedarf.

SEO-Newsletter bestellen

Verwandte Beiträge

ChatGPT: Werbekunden erhalten laut Bericht nur wenige Einblicke in die Anzeigenleistung