Shared Hosting: IONOS blockiert Zugriffe mancher KI-Bots auf Websites

Websites, die unter Shared Hosting von IONOS laufen, sind für bestimmte KI-Bots und KI-Crawler nicht erreichbar. Das kann die Chancen auf Erwähnungen in den KI-Antworten senken.

Damit eine Website in den Antworten von KI-Systemen wie ChatGPT, Perplexity oder Claude genannt wird, ist es wichtig, dass die Inhalte der Website von den Bots und Crawlern dieser Systeme abgerufen werden können. Es gibt verschiedene Möglichkeiten, die Zugriffe solcher Bots zu steuern - zum Beispiel per robots.txt, per Firewall oder durch eine entsprechende Konfiguration im verwendeten CDN.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

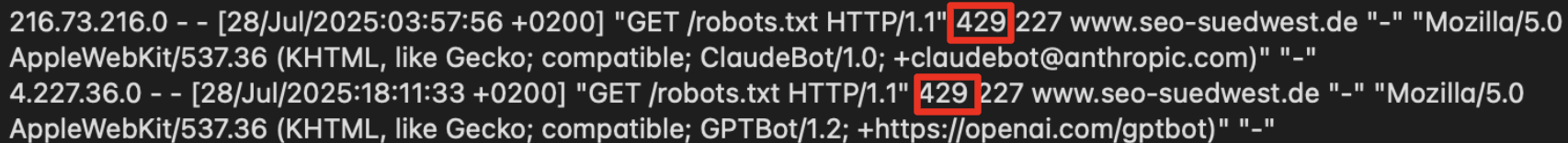

Doch was ist, wenn das genutzte Hosting-Paket Zugriffe der KI-Bots grundsätzlich nicht zulässt? Das ist aktuell der Fall bei manchen Websites, die unter Shared Hosting bei IONOS laufen. Hier werden bestimmte KI-Bots geblockt und können nicht einmal die robots.txt der Website abrufen. Sie erhalten einen HTTP-Fehler mit dem Status 429, der für "too many requests" steht. Auch der Claudebot ist betroffen und erhält auf seine Anfragen ebenfalls den Status 429:

Der GPTBot wird von OpenAI zum Trainieren seiner Modelle verwendet. Andere Crawler von OpenAI können dagegen problemlos zugreifen:

- OAI-SearchBot: wird verwendet für SearchGPT bzw. die Suche-Features in ChatGPT

- ChatGPT-User: wird verwendet, wenn Nutzer Fragen stellen und ChatGPT dazu Webseiten besucht. Kommt auch für CustomGPTs und GPT Actions zur Anwendung.

Auch der Crawler von Perplexity kann auf die Inhalte zugreifen.

Von IONOS gab es auf Anfrage die folgende Antwort dazu:

"Es stimmt, dass ausgewählte KI-Bots derzeit bei einigen Shared Hosting-Paketen ausgeschlossen werden. Die Serverlast ist durch viele KI-Crawler in den vergangenen Monaten enorm gestiegen. Da sich beim Shared Hosting – anders als bei Dedicated Servern – viele Kunden eine Ressource teilen, müssen wir darauf achten, dass wir allen Anwendern eine ausgezeichnete Performance anbieten. Leider halten sich viele Crawler nicht an die üblichen Regeln und verteilen, anders als Suchmaschinen-Bots, oft ihre Last auch nicht über den ganzen Tag, sondern verursachen regelmäßig immense Lastspitzen. Wie aus der Fachpresse bekannt, sind viele Firmen und Projekte von der hohen Request-Rate und den Downloads der KI-Crawler betroffen. Cloudflare sperrt zum Beispiel inzwischen AI-Crawler für Neukunden per Default aus und selbst die Internet Engineering Task Force (IETF) oder die Linux-Kernel-Mailingliste müssen sich mit dieser Problematik auseinandersetzen und arbeiten an entsprechenden Gegenmaßnahmen. Wir sind uns der Auswirkungen bewusst und arbeiten bereits an einer Lösung, die es unseren Kunden ermöglicht, von der Sichtbarkeit in KI-Systemen zu profitieren. Darüber hinaus werden wir demnächst in unserem Blog ausführlich über die Problematik wie auch über mögliche und auch schon praktizierte Lösungsansätze berichten."

Website-Betreibern wird empfohlen, in ihren Access-Logs nachzusehen, ob sie auch von blockierten Aufrufen betroffen sind. Wer dies umgehen möchte, kann zum Beispiel von einem Shared-Hosting-Paket auf einen eigenen Server wechseln.

Danke an Juliane Bettinga, die in ihrem Post auf das Problem bereits hingewiesen hatte.

SEO-Newsletter bestellen

Verwandte Beiträge

Bericht: Perplexity crawlt verdeckt und umgeht Website-Einstellungen