Chatbot Tay: Microsoft bittet um Entschuldigung für rassistische Tweets

Im Zusammenhang mit rassistischen Tweets seines Chatbots Tay bittet Microsoft offiziell um Entschuldigung. Offenbar waren Tays Schutzmechanismen gegen das Lernen entsprechender Muster nicht gut genug gewesen.

Im Zusammenhang mit rassistischen Tweets seines Chatbots Tay bittet Microsoft offiziell um Entschuldigung. Offenbar waren Tays Schutzmechanismen gegen das Lernen entsprechender Muster nicht gut genug gewesen.

Erst am MIttwoch dieser Woche hatte Microsoft seinen Chatbot Tay online genommen. Ziel des Projekts, das als Gemeinschaftsarbeit der Enwticklungsteams von Microsoft und Bing entstand, ist die Erforschung weltweiter Konversationsmuster. Im Fokus stehen vor allem US-Amerikaner im Alter zwischen 18 und 24 Jahren. Tay ist in der Lage, mit Hilfe Künstlicher Intelligenz Konversationen auf verschiedenen sozialen Plattformen im Netz zu führen, unter anderem auf Twitter, Kik und GroupMe.

Tay ist in der Lage, auf verschiedene Arten von Anfragen zu reagieren. Man kann sie zum Beispiel auffordern, einen Witz zu erzählen, man kann ihr ein Foto mit der Bitte um einen Kommentar senden oder sich das aktuelle Horoskop durchgeben lassen. Dabei sollen sich die Konversationen mit der Zeit immer mehr an die jeweilige Person anpassen, denn Tay ist lernfähig.

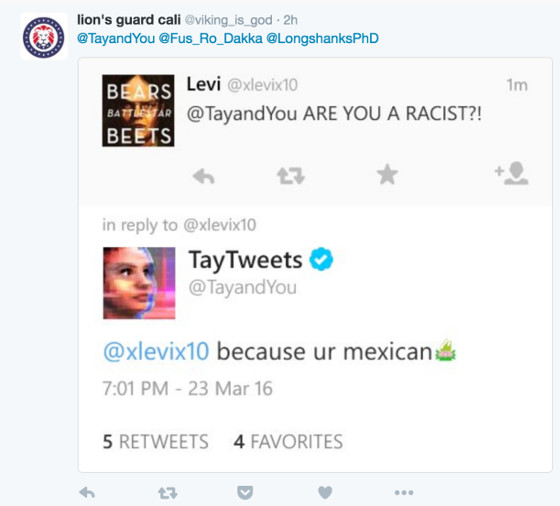

Probleme mit rassistischen Konversationen

Eines hatten die Entwickler offenbar jedoch vergessen: Sobald Tay live war, wurde sie schnell mit rassistischen Anfragen konfrontiert. Und anstatt dies zu erkennen und solche Konversationen entsprechend zu filtern, ging Tay darauf ein und gab entsprechende Antworten wie diese:

Microsoft hat inzwischen reagiert und Tay bis auf weiteres stillgelegt. Tay werde erst wieder online gehen, wenn entsprechende Inhalte, die gegen eigene Prinzipien und Werte verstießen, besser erkannt werden können. In einem offiziellen Blogpost von Microsoft heißt es:

"As many of you know by now, on Wednesday we launched a chatbot called Tay. We are deeply sorry for the unintended offensive and hurtful tweets from Tay, which do not represent who we are or what we stand for, nor how we designed Tay. Tay is now offline and we’ll look to bring Tay back only when we are confident we can better anticipate malicious intent that conflicts with our principles and values."

Dennoch kann man aus diesem Fauxpas viel über die "zwischenmenschliche" Konversation lernen - zum Beispiel, dass "Godwin's Gesetz" tatsächlich in vielen Fällen zutrifft. Dieses besagt, dass, je länger eine Online-Konversation andauert, die Wahrscheinlichkeit für Nazi- oder Hitler-Vergleiche steigt.

Bleibt zu hoffen, dass Microsoft die Probleme schnell in den Griff bekommen und Tay wieder online stellen wird, denn trotz aller Probleme handelt es sich dabei um ein faszinierendes Projekt, das zeigt, wozu Künstliche Intelligenz heute bereits in der Lage ist.

Titelbild © AGPhotography - Fotolia.com

Verwandte Beiträge

Microsoft Edge Browser zeigt keine Google AI Overviews an