Google: Disallow-URLs in der robots.txt beeinflussen nicht das Crawl-Budget

URLs, die in der robots.txt per 'disallow' gesperrt sind, haben keine Auswirkungen auf das von Google gewährte Crawl-Budget für eine Website.

URLs, die in der robots.txt per 'disallow' gesperrt sind, haben keine Auswirkungen auf das von Google gewährte Crawl-Budget für eine Website.

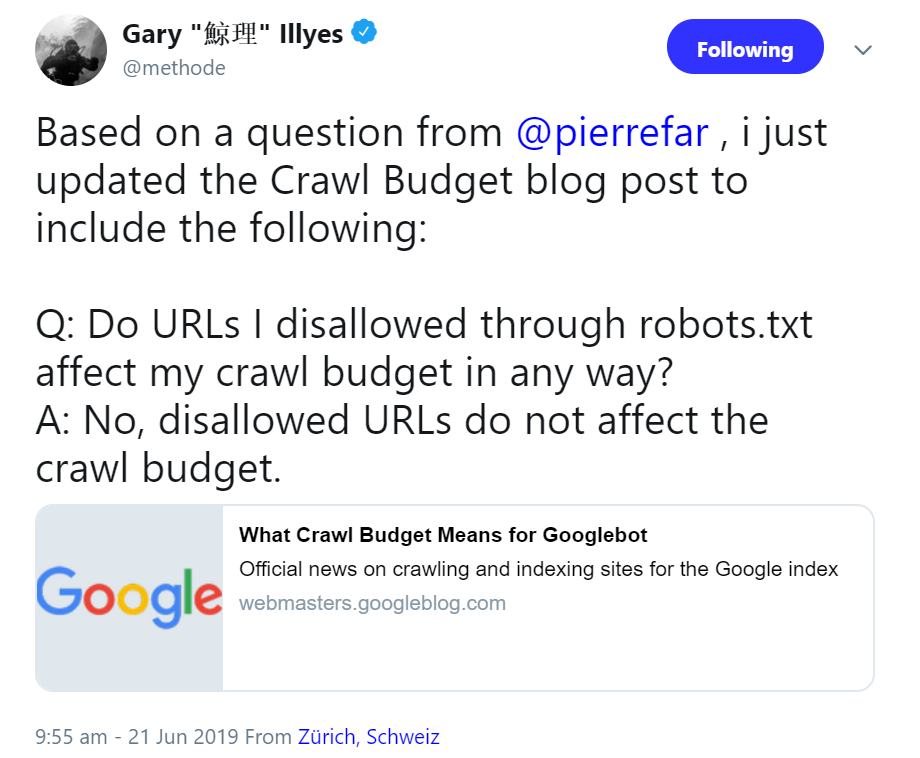

Gute Nachricht für alle diejenigen, die sich Sorgen um ihr Crawl-Budget machen: Für URLs in der robots.txt, die auf "disallow" gesetzt sind, gibt es keine Abzüge. Das hat Gary Illyes von Google jetzt per Twitter mitgeteilt. Er erklärte, der entsprechende Blog-Post "What Crawl Budget Means for Googlebot" sei erweitert worden:

Neu hinzugekommen ist das folgende Frage-Antwort-Paar (Übersetzung Red.):

Frage: Beeinträchtigen URLs, die ich disallowed habe, das Crawl-Budget in irgendeiner Weise?

Antwort: Nein, Disallow-URLs beeinträchtigen nicht das Crawl-Budget.

Das Thema Crawl-Budget wird jedoch ohnehin meist überbewertet. Bei kleinen und mittelgroßen Websites mit einigen Tausend Unterseiten hat Google überhaupt keine Probleme, die Inalte zu crawlen. Interessant wird dies erst bei sehr großen Websites, auf denen es eine Million oder mehr Unterseiten gibt. Hier kann es durchaus sinnvoll sein, sich über die Verteilung des Crawl-Budgets Gedanken zu machen und beispielsweise per robots.txt Einfluss auf den Abruf der Seiten durch den Googlebot zu nehmen.

SEO-Newsletter bestellen

Verwandte Beiträge

Neuer Hinweis von Google: Für Bilder auf einer Website immer dieselbe URL verwenden