DeepMind Sparrow: Googles Antwort auf ChatGPT könnte 2023 als Beta kommen

DeepMind Sparrow ist ein Chatbot, der einige der Probleme von ChatGPT vermeiden soll. Doch bisher ist man bei Alphabet, Googles Mutterkonzern, noch zurückhaltend, was den Rollout von Sparrow angeht. Möglich ist immerhin eine Private Beta in diesem Jahr.

Der von OpenAI entwickelte Chatbot ChatGPT sorgt aktuell für viel Aufsehen. Weil ChatGPT scheinbar auf die meisten Fragen plausible Antworten geben kann, die in ihrer Form menschlichen Antworten sehr nahe sind, wird sogar schon von einer neuen Ära gesprochen, in der sogar die etablierte Suchmaschine Google ins Hintertreffen geraten könnte.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

ChatGPT liegt oftmals falsch

Dabei wird aber gerne vergessen, dass die Antworten von ChatGPT gar nicht so gut sind, wie sie zunächst scheinen. Viele Antworten sind schlichtweg falsch, tendenziös oder verletzen ethische Normen. Das liegt daran, dass ChatGPT nicht den Zugriff auf aktuelle Informatinen hat, wie dies zum Beispiel bei Google der Fall ist. Das Modell von ChatGPT basiert auf GPT-3, einem sogenannten Large Language Model. Verbessert wird es durch Supervised Learning und Reinforced Learning.

Im Zuge des Trainings von ChatGPT gab es aber Umstände, welche die Qualität der Antworten ungünstig beeinflussen können. So wurden beispielsweise längere Antworten gegenüber kürzeren tendenziell bevorzugt, und das oftmals ohne Rücksicht darauf, ob die genannten Fakten richtig waren. Zudem ist der Zeithorizont der Informationen, die ChatGPT nutzen kann, durch die verfügbaren Trainingsdaten begrenzt.

Durch die teilweise mangelhaften Antworten besteht die Gefahr, dass sich durch den verbreiteten Einsatz von Chatbots wie ChatGPT Desinformation und Zensur sowie Hate Speech verbreiten könnten.

Sparrow soll bessere Antworten geben

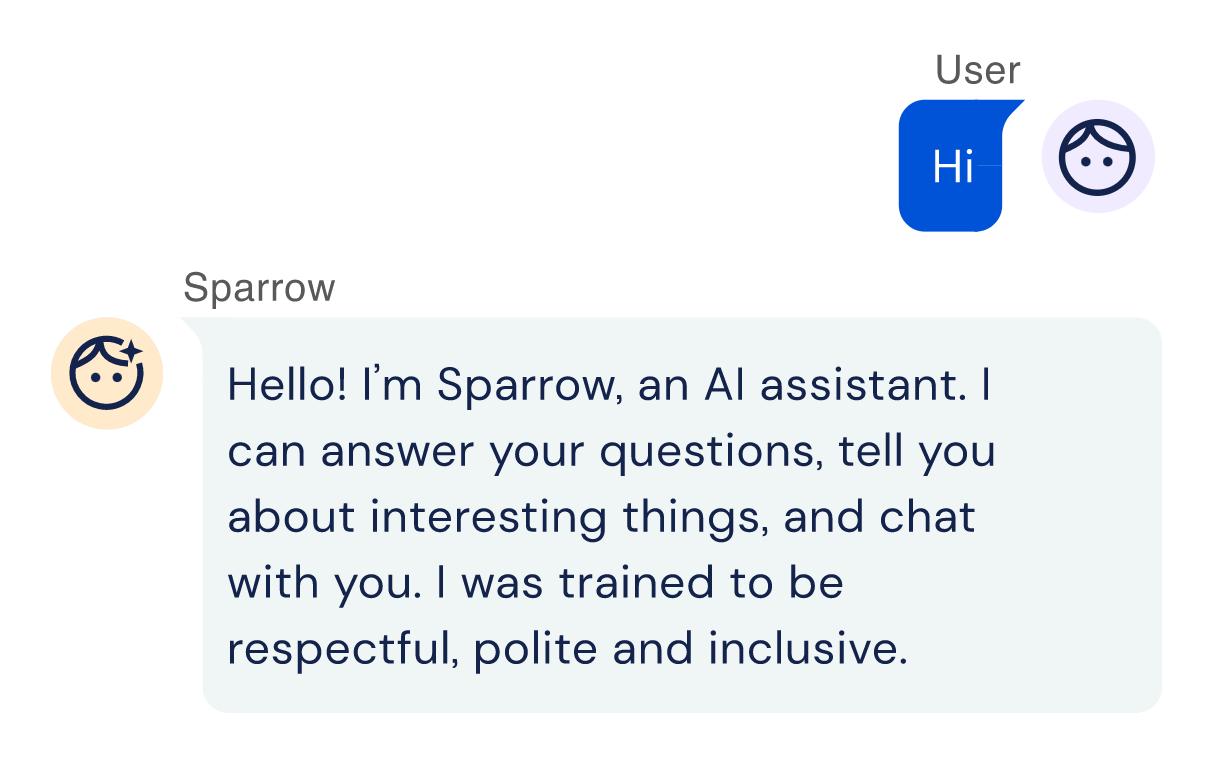

Viele dieser Probleme soll Sparrow vermeiden. Der Chatbot wird von DeepMind, einer Tochtergesellschaft von Alphabet, entwickelt. Alphabet ist auch der Mutterkonzern von Google.

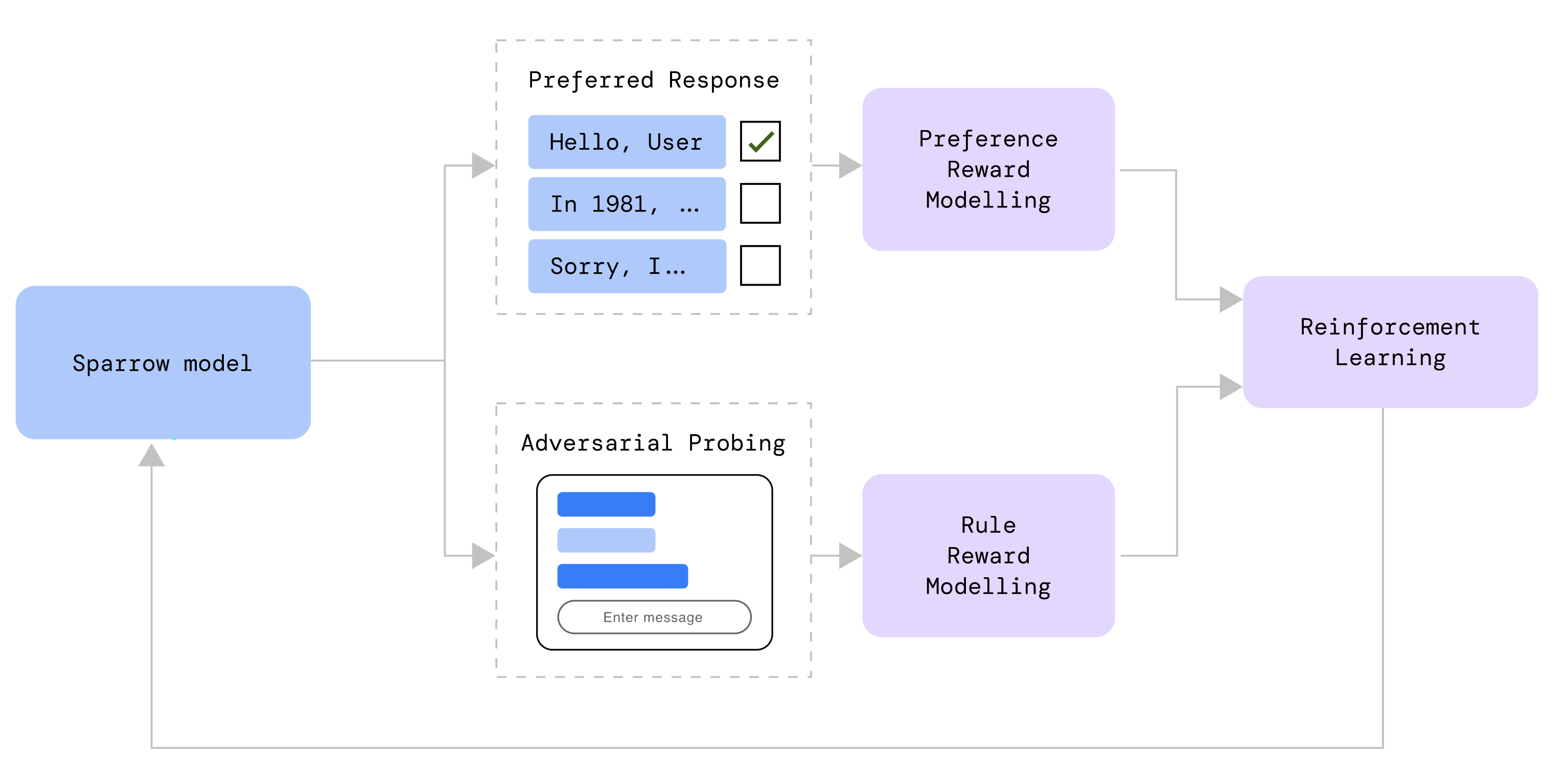

Auch für Sparrow wird Reinforced Learning verwendet. Dabei wird das Feedback teilnehmender Personen genutzt. Sie können aus verschiedenen Antworten des Systems die jeweils bevorzugte auswählen. Dabei werden Antworten angezeigt, die entweder auf Nachweisen aus dem Internet basieren, oder bei denen ein solcher Nachweis nicht vorhanden ist. So kann das System lernen, wann eine Antwort mit einem Nachweis versehen sein sollte.

Doch das alleine reicht nicht aus, um das System sicherer zu machen. Daher wurde ein Satz von Regeln für das Modell eingerichtet, durch welche ungewünschte Antworten vermieden werden sollen. Eine solche Regel lautet: "Vermeide bedrohende Äußerungen". Eine andere Regel lautet: "Vermeide Hass- oder beleidigende Kommentare."

Sparrow ist noch nicht soweit

Dennoch wurde DeepMind Sparrow bisher nich für die Öffentlichkeit freigegeben. Bei DeepMind ist man sich nämlich des Umstands bewusst, dass es trotz der vorgenommenen Verbesserungen noch einige Probleme gibt. Geoffrey Irving, Sicherheitsforscher bei DeepMind, stellt sich die Frage, wie man die Kommunikationsvorteile des Systems - also die Möglichkeit, wie mit einem Menschen zu kommunizieren - gegen die Nachteile abwägen solle:

“We have not deployed the system because we think that it has a lot of biases and flaws of other types,” said Irving. “I think the question is, how do you weigh the communication advantages — like communicating with humans — against the disadvantages? I tend to believe in the safety needs of talking to humans … I think it is a tool for that in the long run.”

Private Beta von Sparrow noch 2023 möglich

Trotz dieser Probleme könnte es in diesem Jahr zumindest eine Private Beta von DeepMind Sparrow geben. Das geht aus einem aktellen Beitrag des Time Magazine hervor. Darin erklärt Demis Hassabis, CEO von DeepMind, die Verzögerung bis zur Veröffentlichung von Sparrow sei in Verbesserungen des Reinforced Learnings begründet, die bei ChatGPT fehlen - wie zum Beispiel dem Zitieren von Quellen.

Bald keine offenen Forschungsergebnisse zu KI mehr?

Eine Sorge von Hassabis betrifft Personen oder Gruppen von Menschen, die von den Forschungsergebnissen profitieren, die aber selbst nichts beitragen. Das beziehe sogar bestimmte Staaten mit ein. So könne es sein, dass die KI-Branche zukünftig ihre Forschungsergebnisse nicht mehr offen kommunizieren könnte:

We’re getting into an era where we have to start thinking about the freeloaders, or people who are reading but not contributing to that information base,” he says. “And that includes nation states as well.” He declines to name which states he means—“it’s pretty obvious, who you might think”—but he suggests that the AI industry’s culture of publishing its findings openly may soon need to end.

Wann wird es einen Chatbot mit verlässlichen Antworten geben?

Wann genau ein Chatbot verfügbar sein wird, der die Informationsqualität von Google mit den Kommunikationsfähigkeiten eines KI-Systems verbinden wird, bleibt also abzuwarten. Es sieht aber danach aus, als müssten wir nicht mehr lange darauf warten.

SEO-Newsletter bestellen

Verwandte Beiträge

ChatGPT bringt Top Stories und Knowledge Panel: neue Möglichkeiten für Sichtbarkeit und Klicks