Google: Erwünschte Crawler nicht fragen, ob sie ein Crawler sind

Crawler bzw. Bots, die auf einer Website zugelassen sind, sollte man laut John Müller von Google nicht fragen, ob sie ein Bot sind, sondern ihnen einfach die gewünschten Inhalte zeigen.

Im Web sind viele Crawler und Bots unterwegs. Dazu gehören Crawler von Suchmaschinen, von SEO-Tools, aber auch von dubiosen Quellen. Nicht alle möchte man auf der eigenen Website haben.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

Um den Zugriff durch Crawler und Bots zu steuern, gibt es verschiedene Möglichkeiten wie zum Beispiel die robots.txt. Weil sich aber nicht alle Bots daran halten, kann auch die Verwendung von Blacklists oder Whitelists mit entsprechenden IP-Adressen eine Alternative sein.

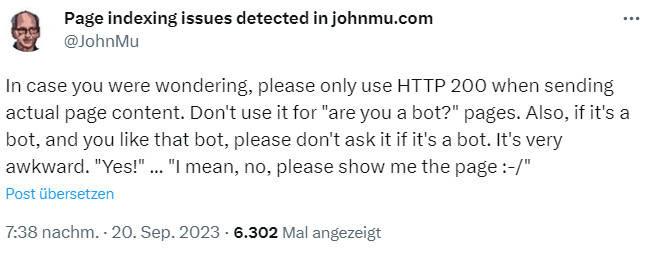

Zwischenseiten, auf denen geprüft wird, ob es sich bei einem Besucher um einen Bot handelt, sollten aber nicht für erwünschte Bots wie zum Beispiel den Googlebot erscheinen. John Müller schrieb auf Twitter, die gewünschten Bots sollten einfach die angeforderten Inhalte erhalten. Auch solle man den HTTP-Status 200 nicht für solche Bot-Zwischenseiten senden, sondern nur dann, wenn die eigentlichen Inhalte der Seite gesendet werden:

Zwischenseiten für erwünschte Bots können ansonsten dazu führen, dass Google und andere Suchmaschinen die Inhalte der betreffenden Seiten nicht crawlen und indexieren können.

SEO-Newsletter bestellen

Verwandte Beiträge

Shared Hosting: IONOS blockiert Zugriffe mancher KI-Bots auf Websites