Google versendet Warnungen bei blockiertem Javascript und CSS

Google versendet per Search Console Warnungen an Webmaster, wenn Javascript- oder CSS-Ressourcen blockiert sind. Im schlimmsten Fall droht ein schlechteres Ranking.

Google versendet per Search Console Warnungen an Webmaster, wenn Javascript- oder CSS-Ressourcen blockiert sind. Im schlimmsten Fall droht ein schlechteres Ranking.

Dass Google Zugriff auf alle Javascript- und CSS-Dateien haben muss, um die Darstellung einer Webseite zu überprüfen, ist nicht neu. Mit Hilfe dieser Dateien kann Google beispielsweise erkennen, ob eine Seite für die Darstellung auf Smartphones optimiert ist.

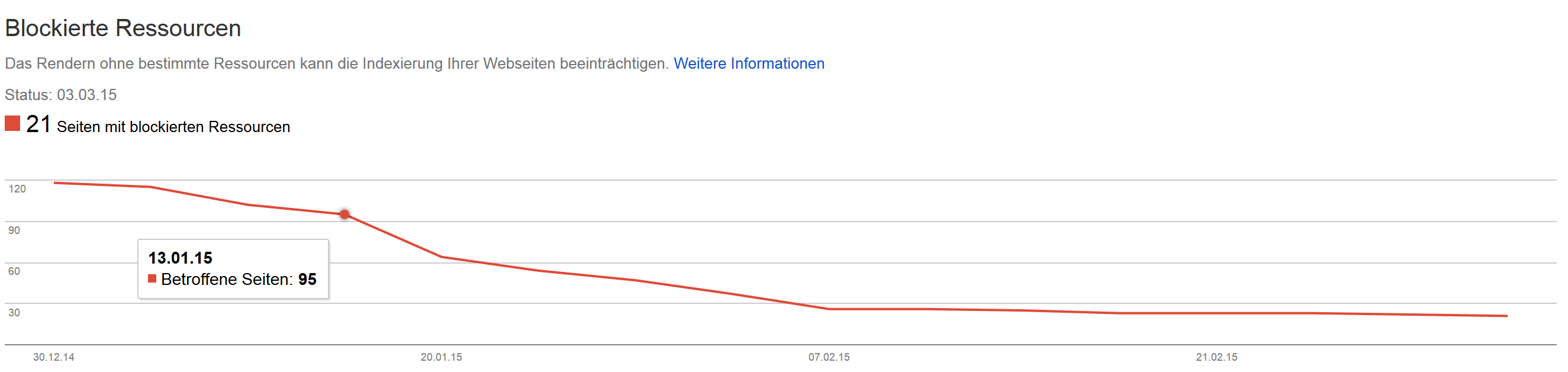

Zur Überprüfung auf blockierte Ressourcen hatte Google erst im März eine neue Funktion in der Search Console eingeführt, die Probleme beim Abruf bestimmter Dateien durch den Googlebot anzeigt.

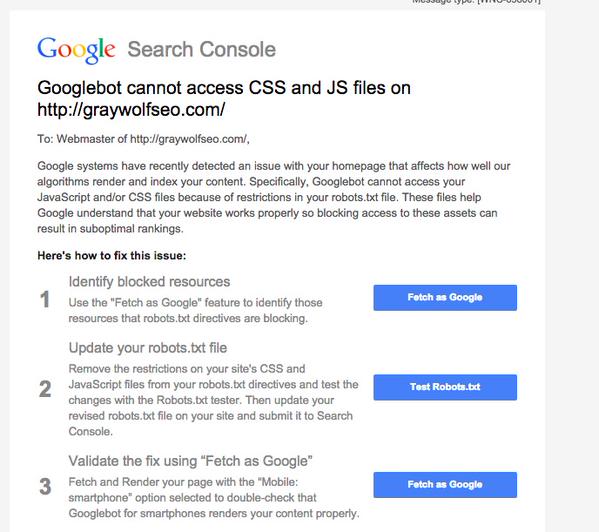

Neu ist, dass Google jetzt auch per Nachricht in der Search Console auf Webmaster zugeht, deren Seiten das Abrufen von Javascript und CSS blockieren. In der Mitteilung heißt es unter anderem, dass als Folge der Probleme ein schlechteres Ranking drohen kann. Gleichzeitig werden in der Nachricht auch Vorschläge zur Behebung der Probleme gemacht:

In der Mitteilung heißt es unter anderem, dass als Folge der Probleme ein schlechteres Ranking drohen kann. Gleichzeitig werden in der Nachricht auch Vorschläge zur Behebung der Probleme gemacht:

- Testen Sie die Seite durch die Funktion "Abruf wie durch Google" in der Google Search Console.

- Beheben Sie die fraglichen Stellen in Ihrer robots.txt

- Nach der Fehlerbeseitigung rufen Sie erneut die Funktion "Abruf wie durch Google" in der Search Console auf.

Neben dem Blockieren von Javascript und CSS gibt es noch viele weitere Ursachen, die zu Problemen beim Crawlen und Indexieren von Webseiten führen können. Welche das sind und welche Lösungen es dazu gibt, lesen Sie hier.

Bild © AKS - Fotolia.com

Verwandte Beiträge

KI: die richtige Content-Strategie für große und kleine Websites