Google: So kann man die Verarbeitung einer neuen robots.txt beschleunigen

Mit Hilfe einer speziellen Funktion in der Google Search Console kann man die Verarbeitung einer neu eingereichten robots.txt beschleunigen.

Mit Hilfe einer speziellen Funktion in der Google Search Console kann man die Verarbeitung einer neu eingereichten robots.txt beschleunigen.

Im Falle einer geänderten robots.txt kann es manchmal auf jede Minute ankommen, wenn verhindert werden soll, dass bestimmte Seiten nicht oder nicht vollständig gecrawlt und indexiert werden. Gerade bei großen Webseiten, die häufig von den Crawlern besucht werden, kann durch falsche Angaben in der robots.txt schnell ein beträchtlicher Schaden entstehen.

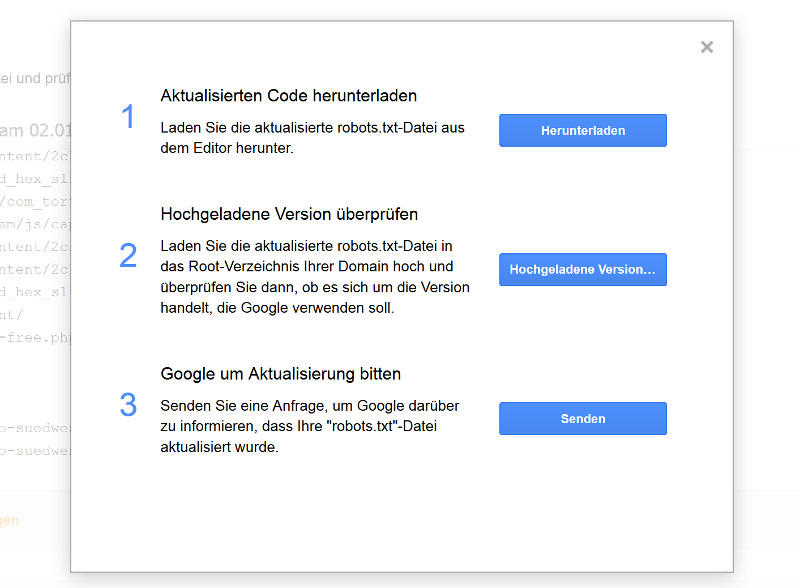

Google benötigt normalerweise bis zu einem Tag, bis eine neu eingereichte robots.txt verarbeitet wird. Zur Beschleunigung dieses Vorgangs gibt es eine Funktion in der Google Search Console. Wie Johannes Müller von Google in einem Forenbeitrag beschreibt, kann man dazu das robots.txt-Tester verwenden, der unter "Crawling" aufgerufen werden kann. Auf der Seite des

robots.txt-Testers klickt man dann auf den "Senden"-Button unten rechts. Danach öffnet sich folgendes Fenster:

Hier klickt man auf "Google um Aktualisierung bitten". Im Text unter dem Button heißt es:

"Senden Sie eine Anfrage, um Google darüber zu informieren, dass Ihre "robots.txt"-Datei aktualisiert wurde."

Müller sagt dazu folgendes:

"One small thing you can do to force a change in the robots.txt file to be reprocessed (usually we do this about once a day, depending on the website) is to use the robots.txt testing tool in Search Console. There you'll see the current known version, and you can submit your new one for reprocessing, if you've since made changes."

Titelbild © AKS - Fotolia.com

Verwandte Beiträge

Google: URLs, die trotz robots.txt indexiert sind, fallen irgendwann aus dem Index