Google: Bug in robots.txt Testing-Tool kann gefährliche Auswirkungen haben

Ein Bug im robots.txt Testing-Tool von Google kann gefährliche Auswirkungen haben, nämlich dann, wenn man auf Basis des Testergebnisses falsche Regeln definiert. Betroffen sind URLs, die prozentkodierte Zeichen enthalten.

Ein Bug im robots.txt Testing-Tool von Google kann gefährliche Auswirkungen haben, nämlich dann, wenn man auf Basis des Testergebnisses falsche Regeln definiert. Betroffen sind URLs, die prozentkodierte Zeichen enthalten.

Per robots.txt lässt sich der Zugriff auf bestimmte Seiten, Dokumente und Verzeichnisse auf einem Server für Crawler sperren. Auch wenn sich nicht alle Crawler daran halten, so respektiert Google diese Anweisungen jedoch.

Fehlerhafte Anweisungen in der robots.txt können aber gravierende Auswirkungen haben. So kann es geschehen, dass man aus Versehen komplette Pfade, Kategorien oder sogar die gesamte Webseite sperrt mit dem Ergebnis, dass diese nicht mehr gecrawlt wird.

Zur Kontrolle der robots.txt bietet Google ein eigenes Tool an, das über die Google Search Console aufgerufen werden kann. Ganz fehlerfrei arbeitet das Tool jedoch nicht: Im Umgang mit URLs, die prozenkodierte Zeichen enthalten, kann es zu Problemen kommen. Eine solche Kodierung empfiehlt Google für Zeichen, die nicht im 7-Bit-ASCII-Zeichensatz enthalten sind.

In einem Blogbeitrag schreibt Giuseppe Pastore über die Probleme des robots.txt Testing-Tools mit solchen prozentkodierten Zeichen. Als Beispiel nennt er einen Fall, in dem alle URLs blockiert werden sollen, die das "<"-Zeichen ("kleiner als") enthalten. Dieses Zeichen lässt sich entsprechend kodieren. Der resultierende Eintrag in der robots.txt wäre dann:

Disallow: /*%3c

Testet man dies im robots.txt Tool, wird jedoch weiterhin bescheinigt, dass der Zugriff erlaubt sei:

Das Problem dabei ist: Wenn man auf Basis des Tools annimmt, eine URL sei weiterhin nicht blockiert und die Regel zum Blockieren verallgemeinert, kann dies unter Umständen zum Blockieren von Seiten führen, die eigentlich für die Crawler verfügbar sein sollen.

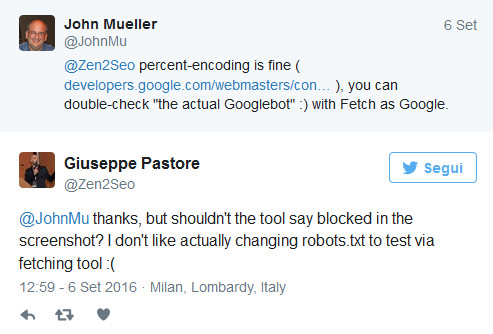

Johannes Müller von Google empfiehlt auf Twitter zur Absicherung die Funktion "Abruf wie durch Google" in der Search Console. Dieses gibt Auskunft darüber, ob eine URL gesperrt ist oder nicht:

Man sollte sich also bei URLs mit prozentkodierten Zeichen niemals auf die Aussage des robots.txt Testing-Tools verlassen, sondern stets auch weitere Prüfungen vornehmen.

Titelbild © AKS - Fotolia.com

Verwandte Beiträge

Google: URLs, die trotz robots.txt indexiert sind, fallen irgendwann aus dem Index