Google: Darum zeigen alte und neue Search Console unterschiedlich viele Serverfehler an

In der alten und neuen Google Search Console kann die Zahl der gemeldeten Serverfehler abweichen. Der Grund dafür ist, dass die Reports unterschiedliche Mengen von URLs berücksichtigen.

In der alten und neuen Google Search Console kann die Zahl der gemeldeten Serverfehler abweichen. Der Grund dafür ist, dass die Reports unterschiedliche Mengen von URLs berücksichtigen.

In der alten Google Search Console gibt es den Bereich "Crawling-Fehler". Dort wird zum Beispiel gemeldet, wenn bestimmte URLs nicht gefunden wurden (404-Fehler). Außerdem wird dort berichtet, wenn es zu Serverfehlern kommt. Damit lassen sich technische Probleme einer Webseite erkennen.

Einen ähnlichen Bericht gibt es auch in der neuen Search Console. Dort findet man im Bereich "Indexabdeckung" Meldungen zu Problemen beim Abruf von URLs durch den Googlebot.

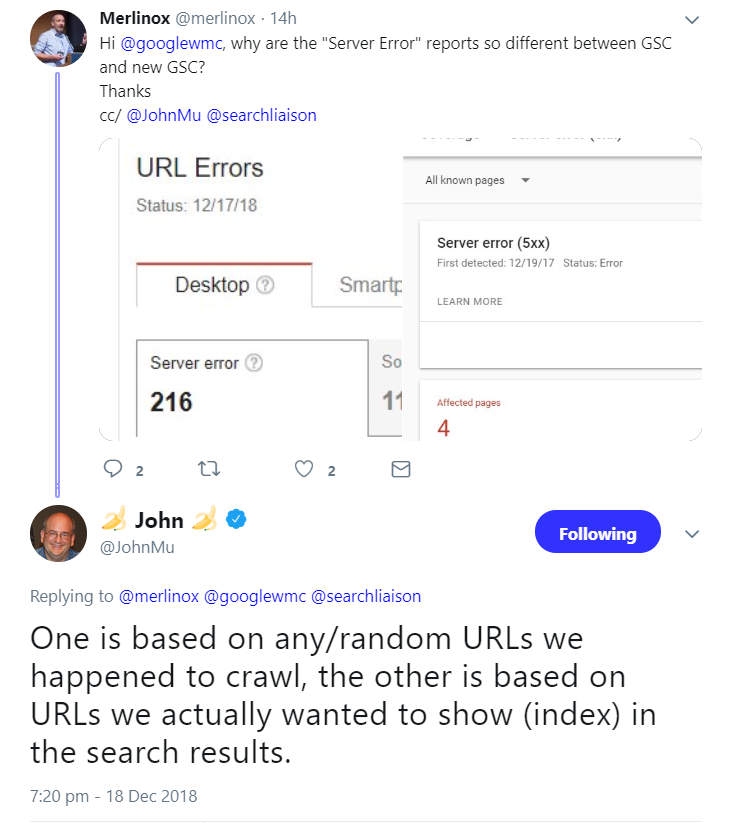

Die Angaben der im alten und im neuen Report gemeldeten Fehler weichen jedoch häufig voneinander ab. Woran das liegt, hat Johannes Müller jetzt in einem Webmaster-Hangout erklärt.

Dies liege daran, dass die alte Search Console alle URLs berücksichtige, auf die der Crawler stoße, während im Bericht der neuen Search Console nur die URLs erwähnt würden, die indexiert sind und auch in der Suche angezeigt werden sollen:

Die Frage ist, welcher Ansatz mehr bietet. In der alten Search Console wird zwar eine größere Menge von URLs berücksichtigt, dafür erhält man aber eventuell auch Informationen, die nicht relevant sind - etwa für falsch verinkte URLs, die es gar nicht gibt. Die Konzentration auf für die Suche relevante URLs in der neuen Search Console zeigt, welche Fehler wirklich wichtig sind.

Titelbild: Copyright WDnet Studio - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

Bing Webmaster Tools jetzt separaten Daten zur KI-Leistung