Studie: inzwischen jeder 25. Googlebot-Besuch gefälscht

Eine neue Studie zeigt: Von 25 Besuchen eines vermeintlichen Googlebots ist einer gefälscht. Die dahinter liegenden Absichten sind oft, aber nicht immer auf Schaden ausgelegt. Wie man schädliche Angriffe erkennen und abwehren kann, zeigt der folgende Beitrag.

Fast jede Webseite wird mehrmals pro Tag von einer großen Zahl an Suchmaschinen-Bots bzw. Crawlern besucht. Meist stammen die Besucher aus dem Hause Google - aber eben nicht immer. Eine aktuelle Studie des Internet-Sicherheitsanbieters Incapsula zeigt, dass jeder 25. Besucher, der sich als Googlebot ausweist, in Wirklichkeit ein Betrüger ist. Die wichtigsten Fakten der Studie zuerst zusammengefasst:

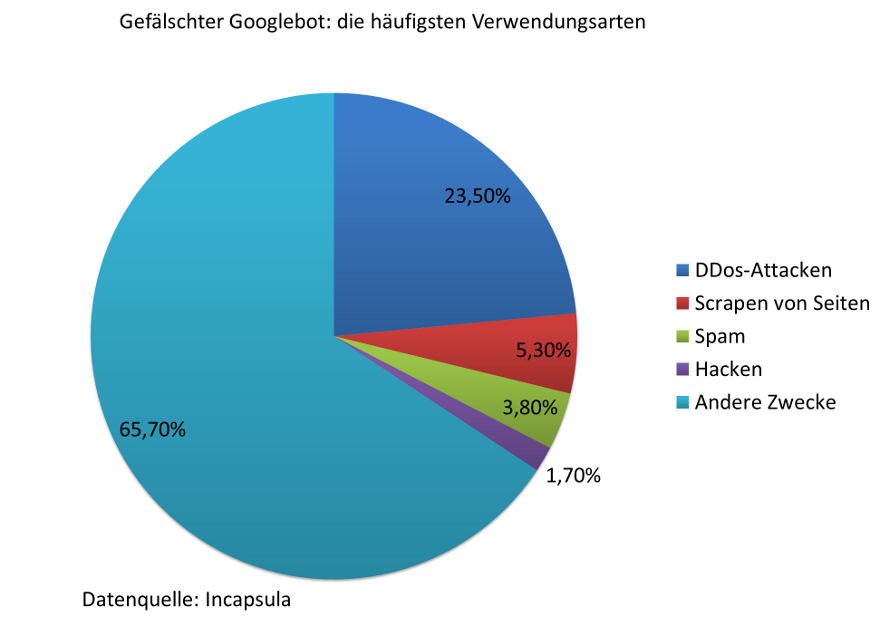

- 4 Prozent aller Googlebots sind gefälscht und haben die Absicht, Seiten zu hacken, mit Spam zu belasten oder Denial-of-Service-Angriffe durchzuführen.

- Mehr als 23 Prozent aller gefälschten Googlebots werden für Distributed Denial of Service-Attacken (DDoS) genutzt.

- Angriffe mit Hilfe gefälschter Googlebots stellen die dritthäufigste Art von DDoS-Attacken dar.

- 25 Prozent aller gefälschten Googlebots stammen aus den USA, 14 Prozent aus der Türkei und 15 % aus China.

- Eine durchschnittliche Webseite wird pro Tag von 187 Googlebots besucht.

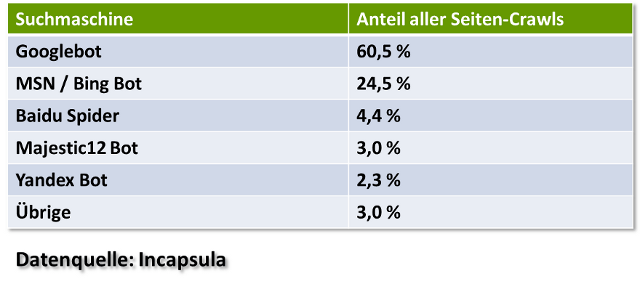

Der Googlebot crawlt mit Abstand die meisten Seiten im Web - mehr als alle anderen Bots zusammen. Mehr als 60 Prozent aller Crawls gehen dabei auf Googles Konto. Dahinter rangiert mit weitem Abstand MSN / Bing, gefolgt von Baidu. Bemerkenswert ist, dass schon auf Platz vier mit Majestic12 ein Bot eines SEO-Tools folgt. Erstaunlich ist außerdem, dass der Yahoo-Bot nicht mehr in den Top-5 vertreten ist. Weitere interessante Erkenntnisse der Studie: Es gibt so gut wie keine Korrelation zwischen der Größe einer Webseite und der Crawlfrequenz, der Crawlrate, der Crawltiefe und der SEO-Performance.

Der Besuch eines Fake-Bots muss nicht immer auf Schaden ausgelegt sein. So kann es vorkommen, dass sich Suchmaschinen-Tools als Googlebot tarnen, um zu testen, wie eine Seite für Google ausgeliefert wird. Man kann jedoch anhand bestimmter Kriterien mit einiger Wahrscheinlichkeit gefälschte und - noch wichtiger - böswillige Besucher erkennen, um sie dann zukünftig auszusperren. Folgende Zwecke werden mit dem Einsatz von Fake-Bots verfolgt:

Fake-Bots erkennen und aussperren

Fake-Bots zu erkennen gelingt am besten durch Kombination mehrerer Schritte. Jeder Schritt für sich gäbe nur ein schwaches Signal, doch in Kombination lassen sich Betrügereien mit einer hohen Wahrscheinlichkeit aufdecken. Das Vorgehen und die Erkennung müssen so ausgelegt sein, dass harmlose Besucher unbehelligt bleiben. So genannte False Positives gilt es zu vermeiden, damit nicht aus Versehen der echte Googlebot ausgesperrt wird und die Webseite nicht mehr gecrawlt werden kann.

- Schritt 1: Header-Daten ansehen. Auch wenn im Header Googles User-Agent steht, so können die anderen Daten doch untypisch sein. Abweichungen vom gewohnten Muster des Headers liefern einen ersten Verdachtsmoment.

- Schritt 2: IP und Zugangsnetz überprüfen. Wem gehören die IP und das Zugangsnetz (Access Service Network bzw. ASN)? Falls sie nicht Google bzw. einem anderen Suchmaschinenanbieter gehören, kann dies durch Verküpfung mit Schritt 1, den Header-Daten, schon hinreichende Verdachtsmomente für eine Einstufung als potentielle Gefahr dienen.

- Schritt 3: Verhalten prüfen. Liegen verdächtige Aktivitäten vor wie eine hohe Abfragefrequenz oder ein Zufallsverhalten? Eine hohe Abfragefrequenz kann für den Versuch einer DDoS-Attacke sprechen. Ein zufälliges "Durchprobieren" ist dagegen ein mögliches Indiz für einen Bot, der Sicherheitslücken aufspüren möchte.

- Schritt 4: Neue Signatur erstellen. Sollte sich durch die vorherigen Schritte ein hinreichender Grund für eine Sperrung ergeben haben, wird eine entsprechende Signatur des Bots bzw. des Zugriffs erstellt und der Datenbank hinzugefügt. So kann der nächste Besuch gleich im Voraus verhindert werden.

Für die genannte Studie wurden mehr als 400 Millionen Besuche von Suchmaschinen-Bots auf 10.000 Seiten über 30 Tage ausgewertet. Das entspricht einer Menge von 2,19 Milliarden Page-Crawls.

Verwandte Beiträge

Shared Hosting: IONOS blockiert Zugriffe mancher KI-Bots auf Websites