Google: Beispiel zeigt deutlichen Zusammenhang zwischen Ladezeit und Crawl-Rate

Wie sehr sich die Ladezeit auf die Anzahl der von Google pro Tag gecrawlten Seiten auswirken kann, zeigt ein aktuelles Beispiel in beeindruckender Weise.

Wie sehr sich die Ladezeit auf die Anzahl der von Google pro Tag gecrawlten Seiten auswirken kann, zeigt ein aktuelles Beispiel in beeindruckender Weise.

Webseiten, die schneller laden, werden vom Googlebot bevorzugt. Das bedeutet, dass Googles Crawler diese Webseiten häufiger besucht und mehr Seiten abruft als von anderen, vergleichbaren Seiten. Das liegt vor allem daran, dass Google eine kurze Reaktionszeit als ein Zeichen für einen intakten Server ansieht. Reagiert ein Server hingegen langsam, deutet das auf Probleme hin, und Google reduziert automatisch die Crawl-Rate. Das gilt insbesondere für sehr große Webseiten mit 100.000 Unterseiten und mehr.

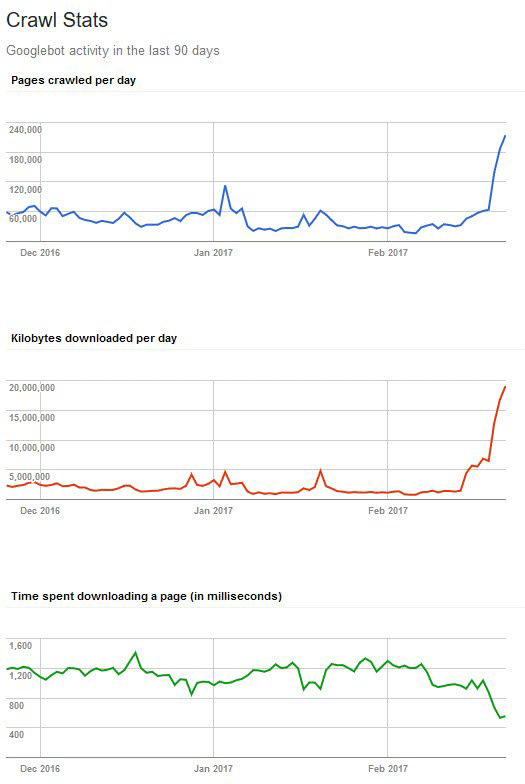

Wie stark der Einfluss der Ladezeit auf die Crawl-Rate im Einzelfall tatsächlich sein kann, zeigt ein aktuelles Beispiel von Rasmus Sørensen. Er konnte die Dauer für das Herunterladen einer Seite in etwa halbieren. Der Wert sank von ca. 1.200 auf etwas über 600 Milisekunden pro Seite. Gleichzeitig stieg die Zahl der vom Googlebot pro Tag gecrawlten Seiten von 60.000 auf etwa 200.000 Seiten an, die täglich abgerufene Datenmenge stiegt von etwa zwei MB auf knapp 20 MB - eine Verzehnfachung.

Dieses Beispiel zeigt, welche Vorteile sich aus einer performanten Webseite ziehen lassen. Dabei muss aber immer die Größe der Webseite bedacht werden. Kleinere Webseiten mit bis zu wenigen Tausend Unterseiten profitieren hier kaum, für sehr große Webseiten wie Online-Shops mit Hubderttausenden von Artikeln lohnt sich die Investition in entsprechende Optimierungen.

Titelbild © jpgon - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

GPTBot auf Platz 3 der meistgenutzten Crawler, Google nach wie vor Nummer 1