'Infinite Space' - wenn es zu viele Links für den Googlebot gibt

Von "Infinite Space" spricht man, wenn es auf einer Webseite zu viele Links gibt, was dazu führen kann, dass das Crawl-Budget nicht optimal genutzt werden kann. Glücklicherweise kann man Gegenmaßnahmen ergreifen.

Von "Infinite Space" spricht man, wenn es auf einer Webseite zu viele Links gibt, was dazu führen kann, dass das Crawl-Budget nicht optimal genutzt werden kann. Glücklicherweise kann man Gegenmaßnahmen ergreifen.

Das Crawlen einer Webseite kann durch eine zu große Zahl von Links auf der Seite beeinträchtigt werden. Vor allem dynamisch erzeugte Links sind dabei kritisch zu betrachten. Wenn der Googlebot und andere Crawler aufgrund der stets neu erzeugten Links aufgehalten werden und als Folge nicht alle relevanten Inhalte einer Webseite erreichen können, spricht man auch vom "Infinite Space"-Problem.

Es gibt mehrere Ursachen, die zu Infinite Space führen können. Besonders häufig anzutreffen sind diese:

- Problematische URL-Parameter wie zum Beispiel Session-IDs oder Parameter zur Sortierung, die vor allem in Kombination miteinander zu einer riesigen Anzahl verschiedener URLs führen können,

- Die Kombination von Filtern, etwa zur Auswahl bestimmter Produktkategorien und Produkteigenschaften,

- Dynamisch erstellte URLs, zum Beispiel für das Vor- und Zurückbkättern in einem Kalender und

- Fehlerhafte relative Links: Diese entsehen, wenn die Pfade der URLs falsch miteinander verbunden werden.

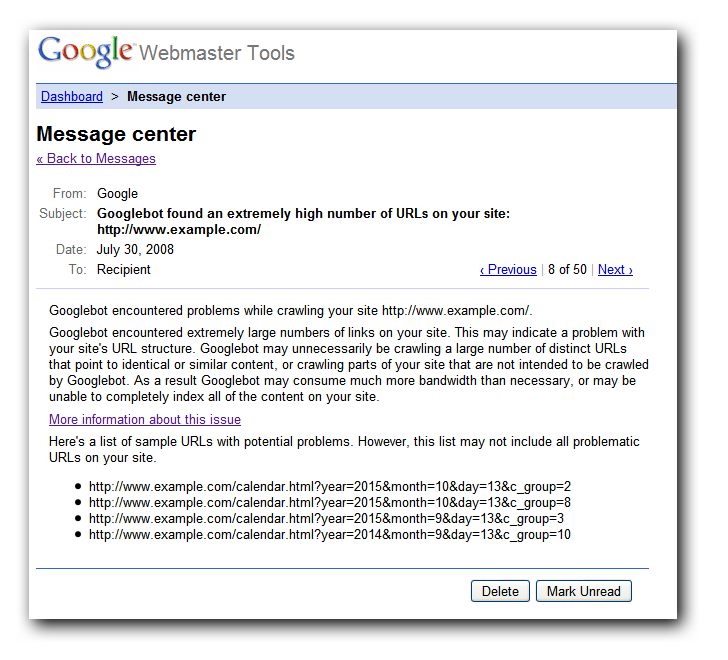

Google versendet für manche Webseiten, auf denen es ein Problem durch Infinite Space gibt, Mitteilungen per Search Console wie diese:

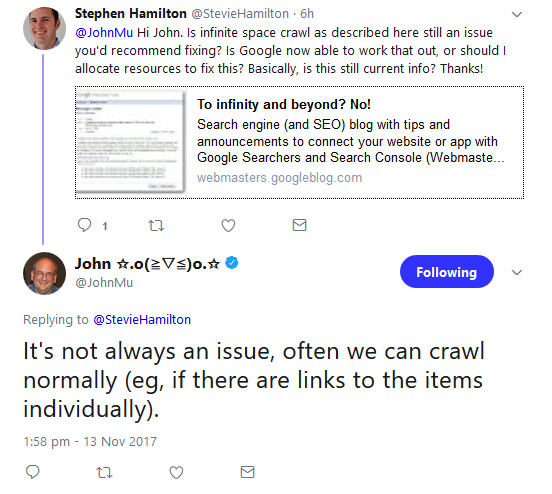

Doch wie kritisch genau ist das Infinite Space-Problem derzeit noch? John Müller von Google hat dazu gerade eine Antwort auf Twitter gepostet.

Laut Müller kann der Googlebot trotz des Infinitive Spaces oftmals die Seiten normal crawlen, zum Beispiel, wenn es individuelle Links zu den verschiedenen Bereichen auf der Seite gibt.

Google empfiehlt die folgenden Maßnahmen gegen Infinitive Spaces:

- Kürzen der URLs und streichen von URL-Parametern, die nicht unbedingt notwendig sind,

- Nutzen des Tools für URL-Parameter in der Google Search Console: Damit kann man Google mitteilen, welche URL-Parameter ignoriert werden können.

- Vermeiden von Session-IDs in URLs,

- Hinzufügen eines "Nofollow"-Attributs zu automatisch erzeugten URLs wie zum Beispiel in einem Kalender,

- Überprüfen, ob alle internen Links funktionieren und fehlerfrei sind,

- Blockieren problematischer URLs durch die robots.txt-Datei.

© mejn - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

KI: die richtige Content-Strategie für große und kleine Websites