Gastbeitrag: SEO Publisher Summit 2019 – All eyes on News-SEO!

SEO ausschließlich für Google News & Co. - das gab es bei der 4. SEO Publisher Summit in Zürich. John Mueller trat als Ehrengast auf und beantwortete sämtliche Fragen rund ums Thema News-Platzierungen.

SEO ausschließlich für Google News & Co. - das gab es bei der 4. SEO Publisher Summit in Zürich. John Mueller trat als Ehrengast auf und beantwortete sämtliche Fragen rund ums Thema News-Platzierungen.

Aufgrund vielfältiger digitaler Geschäftsmodelle und technischer Beschaffenheiten von Websites haben sich verschiedene Fokussierungen bei SEO-Spezialisten gebildet. Für Websites, die eine News-Redaktion betreiben, stellt vor allem News-SEO eine entscheidende Disziplin dar. Platzierungen in Schlagzeilen-Boxen, der Google News App oder Discover als noch recht junger Traffic-Kanal verhelfen bei brisanten Nachrichtenlagen zu außerordentlichen Traffic-Spitzen.

An die Spezialisten des News-SEO richtet sich die SEO Publisher Summit. Hier handelt es sich nicht um eine kommerzielle Konferenz, sondern viel eher um einen Zusammenschluss der SEO-Spezialisten aus den großen Publisher-Häusern Deutschlands, Österreich und der Schweiz. Dabei richtet ein Publisher die Zusammenkunft aus, die gesamte Mannschaft triftt sich beim Publisher vor Ort. Am 26. Juli 2019 luden die SEO-Kollegen von Blick.ch nach Zürich ein, und über 40 SEOs kamen im Headquarter von Ringier zusammen. Mit dabei waren SEO-Spezialisten von der FAZ, Zeit Online, Gruner + Jahr, Springer, Burda, Funke, Welt, DuMont, Spiegel, und Bauer Xcel, aber auch von kleineren regionalen Publishern. Besonders spannend war bei dieser Konferenz die Begegnung mit den direkten SERP-Wettbewerbern. Diese Komponente sorgte für höchst relevante Themen und spannende Einblicke in die Arbeitsweise anderer Medienhäuser.

10 Insights über Google Discover (Welt & Springer)

Der erste Vortrag kam von Florian Elbers von Computerbild/Autobild und Fabian Wurbs von der Welt mit dem Thema „10 Fakten über Discover“. Spätestens seit der Einbindung der Performance-Zahlen in die Google Search Console im April 2019 dürfte jeder SEO-Manager von diesem Kanal gehört haben. Inhalte, die in der Google-App unterhalb der Suchleiste dargestellt und dabei stark personalisiert werden, laufen in der Search Console im Bereich „Discover“ ein.

Fabian Wurbs und Florian Elbers zu Discover, Bildquelle: Tobias Willmann

Fabian Wurbs und Florian Elbers zu Discover, Bildquelle: Tobias Willmann

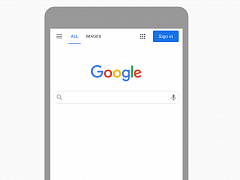

Auf Basis von eigens gesammelten Performance-Zahlen stellten die Referenten gefundene Muster vor und schärften somit die Charaktere von Discover. Mit einem Blick auf die performanten Discover-Stücke laut Search Console Report und dem zugehörigen Quellcode zeigte Florian Gleitkommazahlen, die ein Hinweis auf einen zugewiesenen Ranking-Score sein könnten.

Quelle: Quellcode des Reports zu Discover in der Search Console, Florian Elbers

Der Referrer von Google Discover sei in Analytics-Tools schwer nachvollziehbar. Während Computerbild vor allem mit Tests, Tipps und Ratgebern in Discover erfolgreich sei, berichtete Fabian von Erfolg mit News-Artikeln für eine breite Zielgruppe. Die Besonderheit bei erfolgreichen Discover-Inhalten sei, dass man kein offensichtliches Keyword ermitteln könne, sondern die Inhalte affinen Zielgruppen zugeordnet werden. Laut der Beobachtung von Computerbild ist der Anteil an Artikeln, die nach klassischen Mitteln Google optimiert wurden, in Discover sehr hoch. Laut der Auswertung sind Zugriffe via Discover vor allem abends zwischen 19 und 22 Uhr zu beobachten und stellen daher wahrscheinlich eine Second-Screen-Möglichkeit im Feierabend dar.

Schon während der Präsentation wurde diskutiert, und es wureden Erfahrungen ausgetauscht. So wurde unter anderem der Insight geteilt, dass der Referrer der Google App, in der auch Discover-Inhalte angezeigt werden, www.google.com (ohne Slash) lautet. Auf diese Weise kann zumindest annähernd Discover-Traffic in Analytics-Tools nachvollzogen werden. Zu diesem Thema ist der Artikel von Valentin Pletzer sehr zu empfehlen.

Einführung eines Google-News-Workflows (TV Spielfilm)

Von etablierten Playern bei Google News ging die Veranstaltung über zu einem Newcomer in Sachen Schlagzeilenboxen. Christina Stahl von TV Spielfilm zeigte ihre Vorgehensweise zur Einführung eines Google-News-Workflows mit der eigenen Redaktion auf. Ziel der Redaktion von TVS ist es, bei News-Lagen und Events in den Schlagzeilenboxen der Suchergebnisse aufzutauchen. Christina begann mit ihren Kollegen, vermehrt Nachrichteninhalte zu ausgewählten Events zu erstellen. Dabei berichtete sie von einer Art Schallmauer, die bei der Produktion einer gewissen Anzahl an Stücken durchbrochen schien. Schnell vervielfachte sich der Anteil an News-Traffic, es wurden verstärkt Redakteure ins Boot geholt und Plattform-affine Themen priorisiert. Bislang konnte TVS nicht für vermeintlich zur Website passenden Themen wie TV-Events z.B. „Der Bachelor“ performen. Dafür konnten sie aber bei Events wie dem Eurovision-Song-Contest eine schöne Tages-Performance hinlegen. Zur Sichtbarkeit in den Schlagzeilenboxen sei der Beobachtung nach eine 100%ige AMP-Validität Voraussetzung.

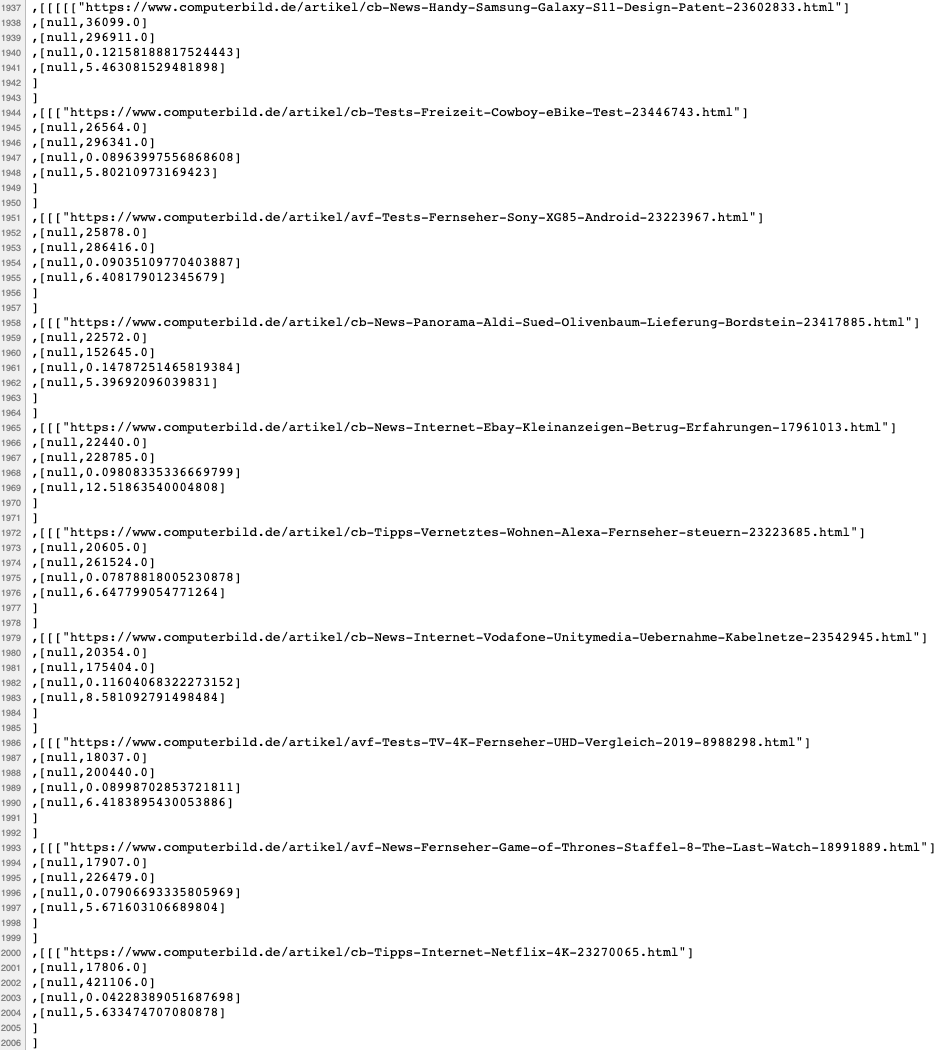

Aufbau und Entwicklung von neuen Taxonomien und Content Clustern (Bauer Xcel Media)

Zu diesem Thema passend ging es mit dem Vortrag von Nadine Mielenz zum Thema „Aufbau und Entwicklung von neuen Taxonomien und Content Clustern“ weiter. Die Audience Development Managerin zeigte Herangehensweisen für Websites auf, die mit Evergreen-Artikeln arbeiten. Dabei sollten vorher zusammenhangslose Tags in eine Baumstruktur umziehen und so Hierarchien und Verwandtschaften der Tags aufgebaut werden. Das Data-Team von Bauer Xcel speichert die vergebenen Tags als Custom Dimension in Analytics und schafft so einen besseren Überblick über zugeordnete Artikel und deren Performance.

Nadine Mielenz: Vorher zusammenhangslose Tags erhalten eine Beziehung zueinander, Bildquelle: Teresa Wolf

Ein ganzheitlicher Export aller Tag-URLs und offenbar aufwändiges Sichten und Überarbeiten war schließlich der erste Schritt. Ein Scoring half bei der Entscheidung, ob die Tag-URL behalten oder weitergeleitet werden soll, und bildete sich aus der Anzahl der vertagten Inhalte, der Anzahl der Sessions im vergangenen Jahr sowie der Anzahl der Backlinks auf die entsprechende Tag-Seite. Nach der fertigen Zuordnung alter und neuer Tags konnte die Entwicklung ran und die Tags löschen oder weiterleiten. Auch beim Aufbau für neue Content-Cluster war viel Detailarbeit gefragt. Nach der Dokumentation einer idealen Hierarchie (z.B. wurden die Themen „Häcksler“ und „Gartenschere“ in das Cluster „Gartengeräte“ einsortiert), fand die Zuordnung des Bestand-Contents statt. In diesem Schritt wurden auch Keyword-Kannibalisierungen korrigiert und schließlich mit Google Data Studio ein Monitoring aufgesetzt. Für die Zukunft sollte außerdem sichergestellt werden, dass kein neuer Wildwuchs an vergebenen Tags entstehen kann.

Alte Tante meets SEO - Redaktionelle SEO-Maßnahmen in einer Print-Redaktion (NZZ.ch)

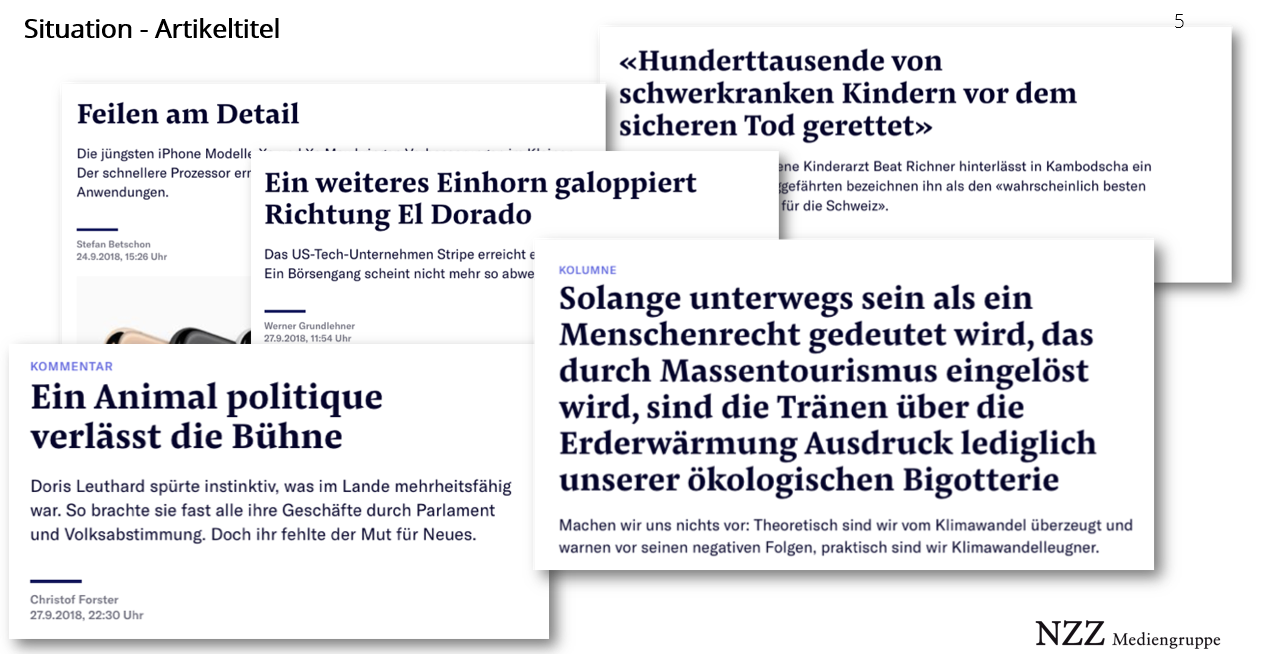

SEO-Newcomer Jonas Holenstein von der Neuen Zürcher Zeitung berichtete auf unterhaltsame Art und Weise, wie er es schaffte, Stück für Stück SEO in der NZZ-Redaktion zu etablieren. Bis zu seinem Start in der bislang auf Print fokussierten Redaktion waren SEO-Denkweisen im Alltag kaum präsent. Er zeigte Headline-Beispiele aus den eigenen Reihen, die für den Googlebot schwer bis gar nicht zu verstehen sind, und machte damit deutlich, dass man hier mit den Grundlagen der Suchmaschinenoptimierung anfangen musste.

Die Kernthemen dieser Headlines sind für den Googlebot unverständlich – für den Menschen in einigen Fällen auch. Quelle: Jonas Holenstein (NZZ)

Mit sogenannten „Ressortübergreifenden Potenzialwochen“ brachte er das Produktmanagement sowie die SEO-Expertise und die Ressorts zusammen. Ziel war es hier, SEO-interessierte Redakteure zu erreichen. Gleich zu Beginn wurden messbare Erfolgsfaktoren definiert: Es sollten 80% aller Artikel SEO-optimiert, eine Steigerung des SEO-Traffics und eine Visibility in den News-Boxen erreicht werden. Jonas' Auswertung zeigt, dass diese Ziele sehr zufriedenstellend erreicht wurden. In der zweiten Etappe, den „Ressortspezifischen Potenzialwochen“, lag der Fokus nun auf dem Erreichen aller Redakteure. Die Awareness für SEO sollte weiter vergrößert werden. Die Redakteure reagierten mal interessiert, mal skeptisch auf den neuen Optimierungsaspekt.

Schließlich hatte es Jonas geschafft, ein Netzwerk an „SEO-Ambassadoren“ und somit eine laufende Kommunikation zu schaffen. Nach der zweiten Runde konnte eine weitere Steigerung des Search Traffics und der Anzahl an optimierten Artikeln verzeichnet werden. Mit einem automatisierten Slackbot, der die Qualität des Meta-Titles bewertet, möchte der NZZ-SEO das Gespür der Redakteure weiter verfeinern. Dem Publikum gefiel der Vortrag von Jonas so gut, dass dieser im anschließenden Voting zum besten Vortrag des Tages gewählt wurde.

Inhouse Tool für Lighthouse + Pagespeed (Blick.ch)

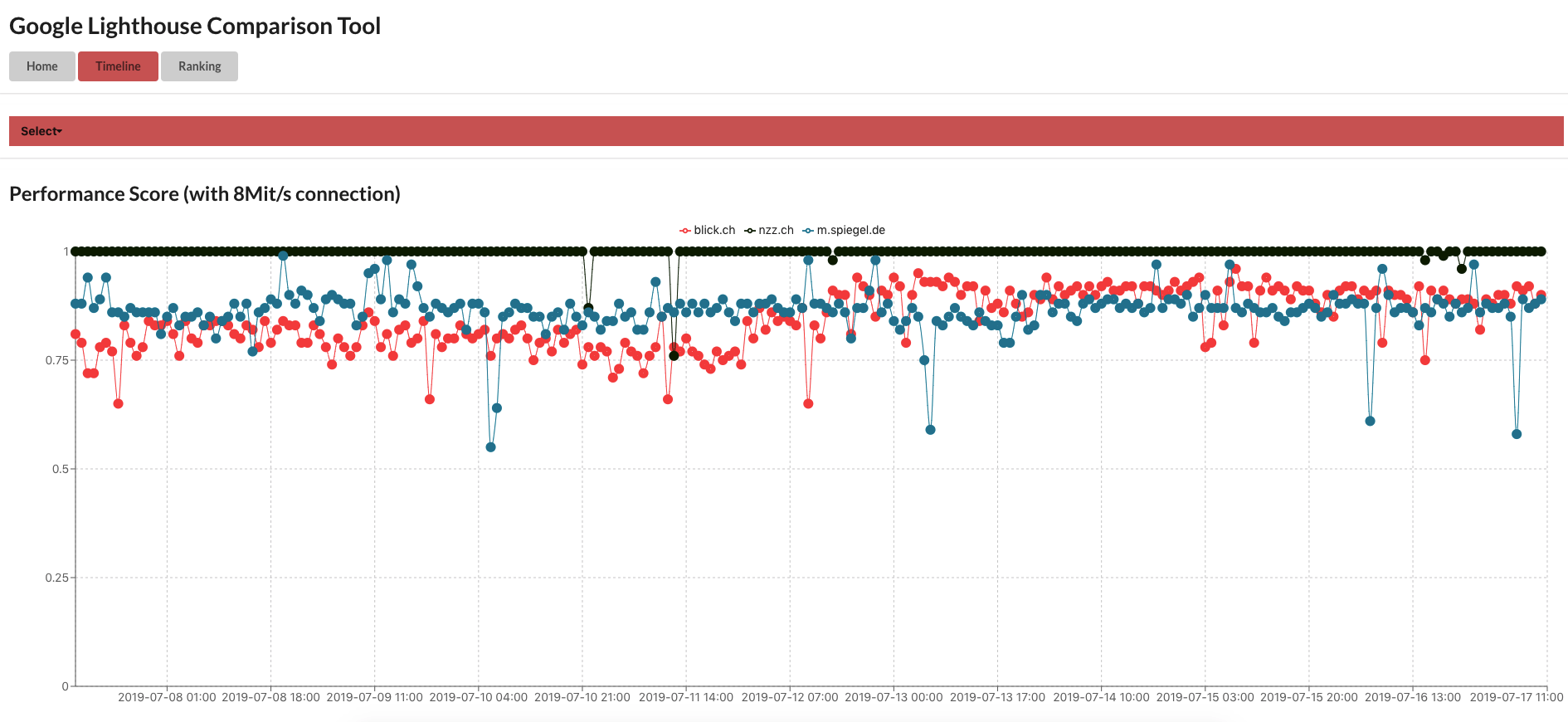

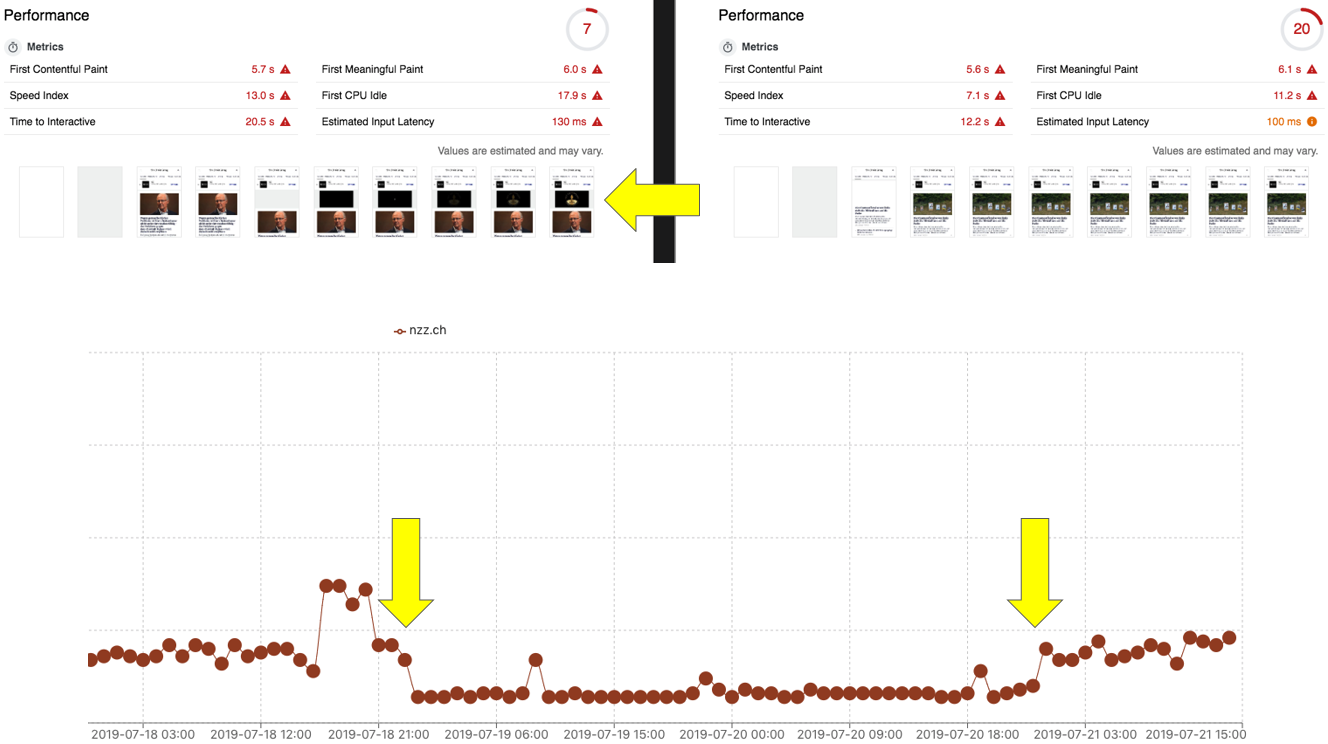

Von der Schreibarbeit zurück zur Technik: Das war der Einsatz für Tobias Willmann und Valerie Lutz, SEOs bei Blick.ch. Die beiden hatten in Eigenregie ein Tool mit den Daten von Lighthouse entwickelt und so eine Möglichkeit geschaffen, die Pagespeed-Performance von Blick.ch zu monitoren. Außerdem konnten auf diese Weise die Ladeperformance direkt neben die der unmittelbaren Wettbewerber gelegt und Werte aus der Vergangenheit nachvollzogen werden.

Ansicht des Performance Scores von Blick, BZZ und Spiegel im hauseigenen Tool von blick.ch. Quelle: Tobias Willmann

Da das Tool den direkten Vergleich einer Landingpage zu verschiedenen Zeitpunkten möglich macht, können so auch historische Veränderungen nachvollzogen werden.

Blick.ch hat einen Blick auf seinen Wettbewerber nzz.ch. Quelle: Tobias Willmann

Das Tool bestätigt die Vermutung: Oftmals sind Werbung und Tracking für hohe Schwankungen des Performance Scores verantwortlich.

Bedeutung und Optimierung von Evergreens (T-Online)

Last but not least war Theresa Futh an der Reihe, Head of SEO bei T-Online. Sie widmete sich intensiv der Analyse und Optimierung von Evergreen-Content. Das redaktionelle SEO-Team von T-Online arbeitet mit zwei News-Schichten und einer Evergreen-Schicht pro Tag. Idealerweise werden hier die Stücke zur Nachoptimierung eingekippt, die den größten Traffic-Hebel versprechen. Mit ihrer Analyse ging Theresa folgenden Fragen auf die Spur: Wie erfolgreich sind nachbearbeitete Artikel? Welche Rubriken bieten das größte Optimierungspotenzial, und welche sind bei Google am erfolgreichsten? Und: Wie groß ist der Traffic-Anteil bei News und Evergreens?

Für ihre Analyse schaffte Theresa folgende Datenbasis: Sie fokussierte sich auf den Zeitraum von Januar 2018 bis Mai 2019. Zusätzlich wurde die Performance in den jeweiligen Monaten in dieser Zeit beobachtet. Bei der Betrachtung der Seitenbereiche wurde auf den Evergreen-Bereich von T-Online geachtet (alle Artikel, die zu „Journal“ gehören). Hier wurden auch die einzelnen Ressorts wie Gesundheit, Auto und Finanzen im Einzelnen betrachtet. Um jedem Artikel einen messbaren Wert zuzuordnen, bildete Theresa einen sogenannten „Artikelwert“. Dieser durchschnittliche Traffic, den ein Artikel innerhalb einer definierten Gruppe geleistet hat, definiert sich folgendermaßen: Traffic-Summe der Gruppe / Anzahl der Artikel. Die Auswertung zeigt: Optimierte Artikel entwickeln sich im Durchschnitt besser als unbearbeitete Stücke.

Theresa unterstrich die Herausforderung, einen Evergreen auch wirklich als solch einen zu erkennen. Manche Artikel werden als Evergreen konzipiert, zünden jedoch nicht. Manche News-Artikel hingegen, die vom Redakteur als Nachricht und nicht als Langzeit-performendes Stück gedacht wurden, mausern sich zum Dauerbrenner in den SERPs. Mittels Custom Dimension im Analytics-Tool und regelmäßigen Datenexport kann eine Übersicht über die wichtigsten Evergreens und ihre Entwicklung gelingen. Genauer wird Theresa bei der SEOkomm in Salzburg darüber referieren.

Fragestunde: Insights von John Mueller zu News-SEO

Bereits am Vormittag der Veranstaltung stellte sich heraus, dass der angekündigte Überraschungsgast John Mueller von Google sein wird. Nach den Vorträgen der SEO-Experten war es soweit, und John stand den Teilnehmern gegenüber. Im Folgenden sind die spannendsten Fragen und Antworten aufgeführt, die im Rahmen der zweistündigen Fragerunde aufkamen.

John Mueller von Google und die Moderatorin des Events, Veronika Kuchynskaya

Gerade für Websites mit sehr vielen URLS ist Crawl Budget ein wichtiges Thema. In wie weit sollten Publisher darauf achten?

John: Das Crawling hängt von mehreren Faktoren ab, zum Beispiel wie schnell der Server ist und wie schnell der Content geladen wird. Das Crawling wird standardgemäß über den Tag verteilt. Wenn der Googlebot verstärkt Server-Fehler feststellt, drosseln wir das Crawling am nächsten Tag um die Server der Website zu schonen.

Wir ziehen in Erwägung ,die Breadcrumbs in der Mobile View auszublenden. Wäre das für Google ein Problem?

John: Nein, das ist an sich kein Problem. Es ist aber hilfreich, die Breadcrumbs über strukturierte Daten zu übermitteln und so für eine optimale Darstellung in den SERPs zu sorgen.

Viele Publisher arbeiten mit Partnern zusammen und stellen deren digitalen Service als Whitelabel bereit, meist auf einer Subdomain. Welche Einstellung hat Google zu solchen Geschäftsmodellen?

John: Solche Modelle haben Ähnlichkeit mit Paid Placement auf der eigenen Website. Unsere Quality Rater stoßen immer wieder auf diese Whitelabels und wollen hier gerne die Qualität noch mehr in den Griff bekommen. Unsere Algorithmen könnten hier Probleme haben, die Hauptthematik der damit verbundenen Haupt-Domain korrekt einzuordnen. Es ist noch nicht entschieden, wie mit Whitelabels zukünftig umgegangen wird, das wird sich noch zeigen. (Anmerkung: Einige Wochen später setzte Google diesen Plan in die Tat um. Bei einigen Whitelabel-Angeboten waren deutliche Sichtbarkeitsverluste sichtbar.

In der Welt des Publishings werden immer wieder gut gelaufene Inhalte des Vortags auf einer neuen URL veröffentlicht und die alte URL weitergeleitet. Welche Haltung hat Google dieser Praktik gegenüber und könnte man dafür eine Abstrafung erhalten?

John: Nein, hier braucht man keine Abstrafung zu befürchten, da wir hier keinen Nachteil für den User sehen. Dieses Thema sollte wenn dann Google algorithmisch in den Griff bekommen.

Das Thema „Discover“ ist für Publisher der neue Hype. Welche Referrer sind für die Daten in dem Discover-Bereich in der Search Console verantwortlich?

John: Das kann ich leider im Detail nicht sagen. Um Discover kümmert sich ein anderes Team.

Bei der Herausgabe von Agenturmeldungen stellen verschiedenste Publisher zum gleichen Zeitpunkt sehr ähnliche Inhalte bereit. Wie wird über die Top-Platzierungen in den Schlagzeilenboxen entschieden?

John: Wir indexieren alle gefundenen Seiten und versuchen dann, eine Seite auszuwählen. Dabei spielt Geschwindigkeit eine große Rolle. Auch die Qualität der Website overall ist entscheidend.

Als große Website beobachten wir immer wieder Links von fragwürdigen Quellen. Ist ein Link-Audit empfehlenswert?

John: Vor allem bei älteren Domains braucht man sich hier keine Sorgen machen.

Es ist bekannt, dass Google Links auf Seiten mit einem „noindex“-Tag weniger bis nicht mehr crawlt. Kannst du uns Empfehlungen für eine korrekte Paginierung geben?

John: Es ist in der Tat so, dass wir die Links auf noindex-Seiten langfristig ignorieren. Wenn man zum Beispiel eine Paginierung eingebunden hat und alles ab Seite 2 auf noindex steht, werden die Links auf der ersten Seite voll berücksichtigt, auf der zweiten Seite noch ein bisschen. Ab Seite 3 ignorieren wir die Links weitestgehend. Damit wir die Website und ältere Artikel gut verstehen können, könnte man mit Tag-Seiten oder mit Kategorie-Seiten arbeiten.

Angenommen, man stellt nun sämtliche paginierten Seiten auf index. Beeinflusst dies nicht das Crawling-Budget negativ?

John: Die Herangehensweise ist eine Option. Um bei sehr langen Paginierungen das Indexieren zusätzlicher Seiten vorzubeugen, könnte man die ersten 10 Seiten auf index stellen und alle weiteren auf noindex belassen.

Hat Google Probleme mit Teasern, die via Javascript geladen werden?

John: Bei einzelnen Teasern sollte es keine Probleme geben. Wenn die gesamte Seite via Javascript geladen wird, könnte Google Probleme haben, die Inhalte sofort zu verstehen. Bei News-Artikeln versuchen wir, sehr zügig zu rendern, um dem User möglichst schnell die neusten Infos zu liefern.

Wir sind ein regionaler Publisher und stellen regionale Nachrichten zur Verfügung. Oftmals sind wir die ersten, die die entsprechende Information bereitstellen. Trotzdem schaffen wir es nicht in die Schlagzeilenbox. Regelmäßig beobachten wir größere Wettbewerber, die uns zitieren und schließlich mit dieser Info in den Schlagzeilenboxen auftauchen. Wie geht Google hier vor?

John: Das sollte so definitiv nicht sein. Wenn ihr solch einen Fall beobachtet, wendet Euch gerne direkt an mich.

Wie gut kommt Google mit Infinity Scroll klar?

John: Das ist an sich kein Problem, es sei denn, unter einem Artikel kommt direkt der nächste (unter der selben URL). Hier könnten wir Probleme haben, diese URL einem Hauptthema zuzuordnen.

Wann werden neue amerikanische Features bei den AMP Stories auch in Deutschland ausgerollt?

John: Dazu kann ich leider nichts sagen. In Deutschland ist es aufgrund einer anderen Gesetzeslage manchmal schwieriger, die amerikanischen Features auszurollen, daher gibt es immer wieder Verzögerungen.

Was hat dich in letzter Zeit so richtig überrascht?

John: Mich hat es überrascht und auch gefreut, wie gut bei der robots.txt-Standardisierung zusammengearbeitet wurde, vor allem auch mit anderen Suchmaschinen. Mich haben auch die Dinge überrascht, die nicht passiert sind. Zum Beispiel haben wir mit einer stärkeren Entwicklung von Voice Search gerechnet. Das ist so nicht eingetreten.

Wir beobachten, dass manche News-Artikel oftmals kurz indexiert sind und dann wieder aus dem Index fliegen. Wie ist das zu erklären?

John: Neue Inhalte versuchen wir sehr schnell zu indexieren. Danach kommen sie manchmal in einen anderen Index. Am Tag danach erkennen wir schließlich, dass diese Inhalte doch nicht so relevant sind wie angenommen, und dies kann zur Deindexierung führen.

Welche Bedeutung hat die URL beim Ranking?

John: Wir nutzen die URL lediglich als Identifier und verwenden die Begriffe in der URL als einen sehr kleinen Ranking Faktor.

In der Vergangenheit stellten Publisher auch Inhalte mit Affiliate-Angeboten bereit. Mittlerweile sind Platzierungen für transaktionale Suchanfragen sehr schwer zu erreichen, und die Publisher werden zunehmend von Shops verdrängt. In wie fern macht dieses Geschäftsmodell für Publisher noch Sinn?

John: In diesem Bereich ist die Konkurrenz einfach immer stärker geworden, und die Bedürfnisse des Users haben sich verändert. Dies führt zur Veränderung in den SERPs. Letztendlich gilt, dass man den User Intent befriedigen muss, dann kann man nach wie vor gute Platzierungen erreichen.

Welche Auswirkung haben Serverfehler (Status Code 5XX)?

John: Wir achten verstärkt auf die Zeit, die es braucht, um die HTML-Seite herunterzuladen. Außerdem haben wir „Time To First Byte“ im Blick, um festzustellen, ob der Server überhaupt reagiert. Ist das nicht der Fall, gehen wir behutsamer vor und crawlen am nächsten Tag langsamer.

Wird überprüft, ob die mit strukturierten Daten ausgezeichneten Breadcrumbs der für den User sichtbaren Breadcrumbs entsprechen?

John: Wir versuchen, dies ab und an zu überprüfen.

Sollen wir bei gelöschten Artikeln lieber den Statuscode 404 oder 410 verwenden?

John: Das macht für uns keinen großen Unterschied, bei beiden Statuscodes findet eine Deindexierung statt. Sendet man einen 410-Statuscode, erfolgt die Deindexierung ca. um einen Tag schneller.

SEO Publisher Summit ab jetzt im Verein

Zum Abschluss gab es noch ein Gruppenfoto, das von Tobias Willmann auf Twitter geteilt wurde. Die Messlatte für die SEO Publisher Summit ist definitiv hoch angesetzt, und die Teilnehmer freuen sich bereits auf die nächste Runde. Diese wird voraussichtlich bei Spiegel Online stattfinden und zukünftig unter dem Schirm des Vereins „OP Next“ organisiert werden.

SEO-Newsletter bestellen

Verwandte Beiträge

Google Discover erhält zusätzliche Inhalte aus sozialen Medien und Follow-Möglichkeit