Google: bei Open Redirects nicht die Crawl-Rate des Googlebots reduzieren

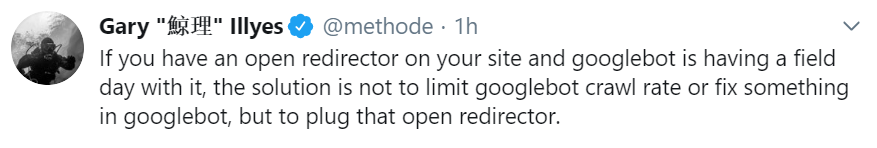

Wenn es auf einer Website ein Sicherheitsproblem mit Open Redirects gibt, sollte man nicht die Crawl-Rate des Googlebots reduzieren, sondern die Sicherheitslücke stopfen. Darauf hat Gary Illyes von Google hingewiesen.

Wenn es auf einer Website ein Sicherheitsproblem mit Open Redirects gibt, sollte man nicht die Crawl-Rate des Googlebots reduzieren, sondern die Sicherheitslücke stopfen. Darauf hat Gary Illyes von Google hingewiesen.

Open Redirects sind ein Sicherheitsproblem auf manchen Websites. Das Problem besteht darin, dass beliebige Redirects per URL-Parameter ausgeführt werden können, weil diese vor der Ausführung von der betreffenden Website nicht geprüft werden. Beispiel: In der URL beispiel.de/login.html?RelayState=http%3A%2F%2Fbeispiel.de%2Fnext gibt der Parameter 'RelayState' an, auf welche URL nach dem Login weitergeleitet werden soll, und zwar auf http://beispiel.de/next.

Wenn hier nicht geprüft wird, welches Ziel im URL-Parameter angegeben wird, kann dies zum Beispiel für Phishing-Attacken genutzt werden. In einem Angriffssznario könnte zum Beispiel der entsprechende Parameter in einer langen URL versteckt werden, um die Nutzer nach dem Login auf eine nachgebaute Seite zu leiten.

Auch im Hinblick auf Google können Open Redirects problematisch sein, weil dadurch praktisch beliebige Weiterleitungen möglich sind. Dadurch kann die Anzahl der vom Googlebot zu crawlenden URLs stark ansteigen.

Wenn die eigene Website von Open Redirects betroffen ist, sollte man aber nicht damit reagieren, die Crawl-Rate des Googlebots zu reduzieren (entsprechende Einstellungen sind in der Google Search Console möglich). Besser ist es laut Gary Illyes von Googe, die Sicherheitslücke zu stopfen, Das schrieb er gerade auf Twitter:

Es gibt verschiedene Möglichkeiten, eine Open Redirect Vulnerability zu beheben. Dazu gehören das Validieren der im Parameter angegebenen URLs sowie das Prüfen gegen eine Whitelist, in welcher erlaubte URLs enthalten sind.

Titelbild: Copyright lotharnahler - Fotolia.com

SEO-Newsletter bestellen

Verwandte Beiträge

GPTBot auf Platz 3 der meistgenutzten Crawler, Google nach wie vor Nummer 1