Google verarbeitet nur die ersten 500 KB der robots.txt

Bei zu großen robots.txt-Dateien kann es sein, dass Google nicht alle Direktiven verarbeitet, denn nur die ersten 500 KB werden berücksichtigt.

Die robots.txt einer Website ist wichtig, um festzulegen, welche Crawler bestimmte Seiten oder Verzeichnisse der Website besuchen dürfen und welche nicht. Außerdem sind in einer robots.txt Zusatzinformationen zu finden wie zum Beispiel Verweise auf bestehende XML-Sitemaps.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

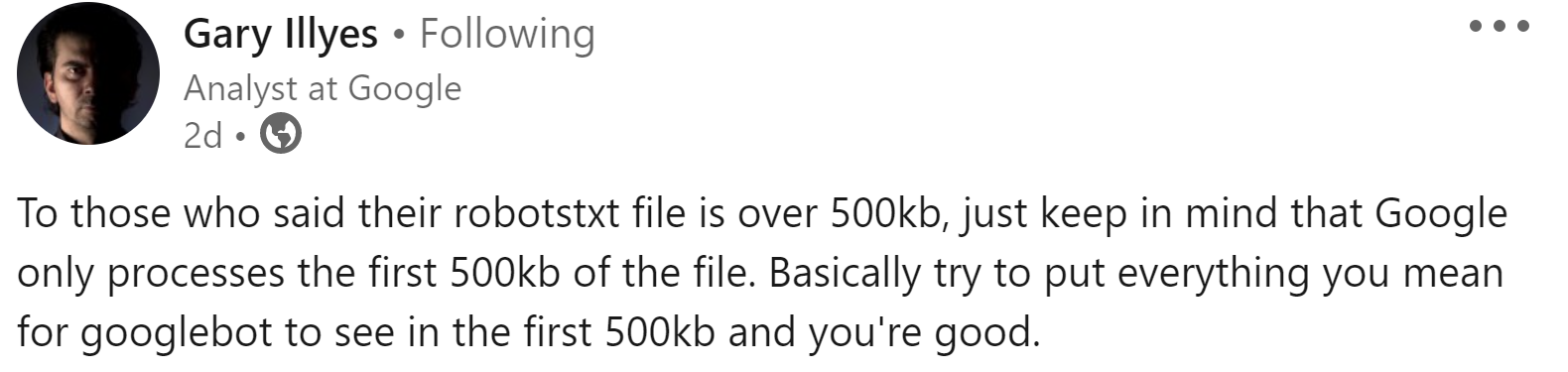

Normalerweise sind robots.txt-Dateien eher klein und enthalten nur wenige Anweisungen bzw. Direktiven. Es kann jedoch auch zu größeren robots.txt-Dateien kommen. Überschreitet die Dateigröße der robots.txt 500 KB, verarbeitet Google nicht mehr die komplette Datei. Gary Illyes wies auf LinkedIn darauf hin, dass Google nur die ersten 500 KB von robots.txt-Dateien berücksichtigt:

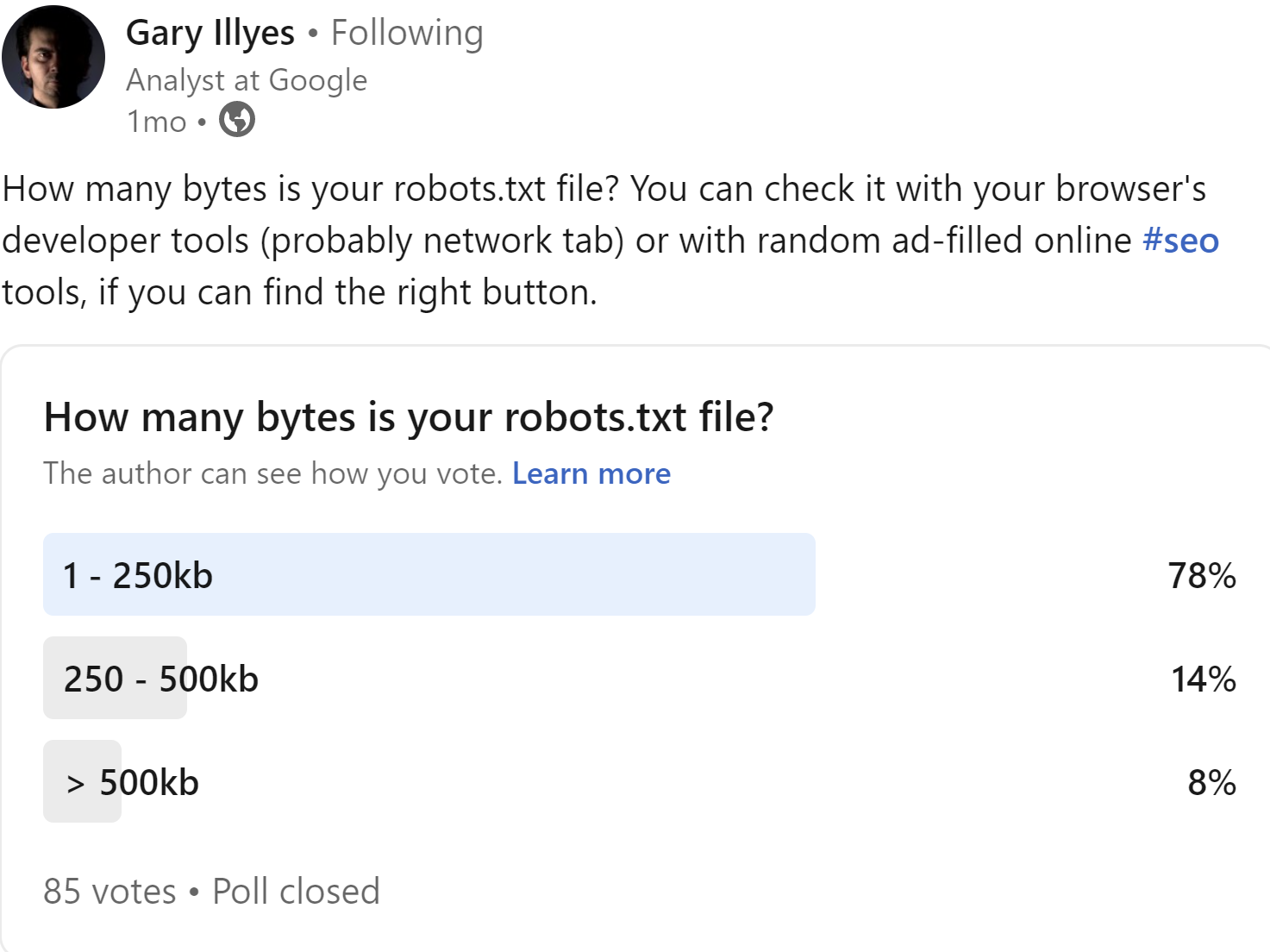

Nach einer kleinen, nicht repräsentativen Umfrage, die Illyes durchgeführt hat, überschreiten etwa acht Prozent der robots.txt die Grenze von 500 KB:

Die Größe der robots.txt lässt sich zum Beispiel mit den Developer Tools des Browsers testen. Ist die robots.txt zu groß, sollte man prüfen, ob sich einzelne Direktiven, zum Beispiel für bestimmte URLs, zu allgemeineren Direktiven zusammenfassen lassen, die zum Beispiel auf Verzeichnisebene greifen.

SEO-Newsletter bestellen

Verwandte Beiträge

Google: URLs, die trotz robots.txt indexiert sind, fallen irgendwann aus dem Index