Neuer robots.txt-Report in Google Search Console mit Notfall-Funktion

Die Google Search Console hat einen neuen robots.txt-Report erhalten. Dafür wird der alte robots.txt-Tester eingestellt.

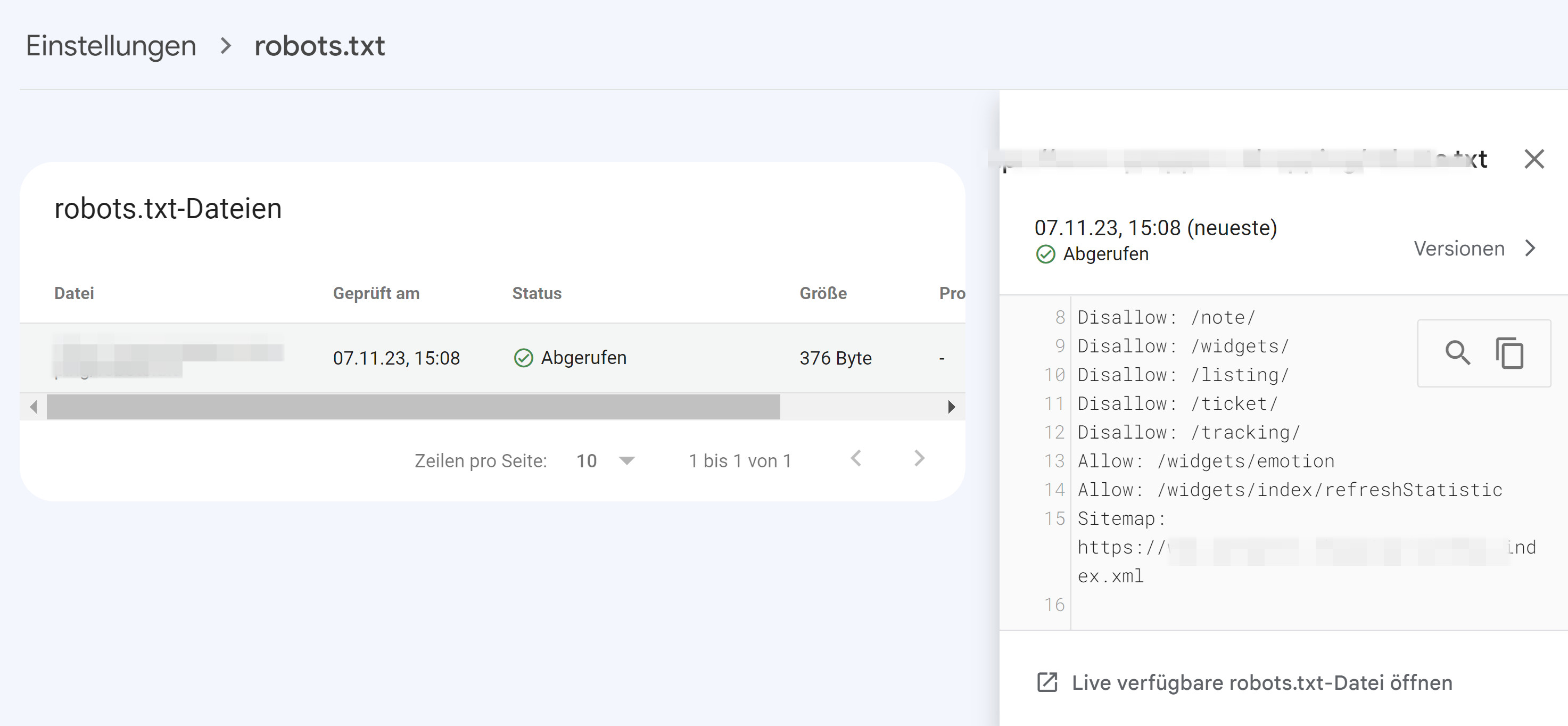

Seit heute gibt es einen neuen robots.txt-Report in der Google Search Console. Dort werden die robots.txt-Dateien der 20 wichtigsten Hosts einer Website angezeigt sowie weitere Angaben zu den einzelnen Dateien.

Der robots.txt-Report steht im Bereich "Einstellungen" zur Verfügung, allerdings nur für Domain Properties sowie URL-Prefix Properties, nicht jedoch für Properties mit einem Pfad wie https://beispiel.de/pfad.

Innerhalb des Reports werden verschiedene Informationen angezeigt:

- Der Pfad zur robots.txt

- Den Status beim letzten Versuch durch Google, die robots.txt abzurufen

- Den Zeitpunkt, zu dem Google das letzte Mal versucht hat, die robots.txt zu crawlen

- Die Größe der Datei

- Aufgetretene Probleme beim Parsen der robots.txt

Zudem kann man sich die letzte abgerufene Version der robots.txt sowie frühere Versionen anzeigen lassen, was zum Beispiel bei der Fehlersuche hilfreich sein kann.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Website nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

Für Notfälle gibt es die Möglichkeit, das erneute Crawlen der robots.txt durch Google anzustoßen. Das kann zum Beispiel dann erforderlich sein, wenn man dringende Änderungen an der robots.txt durchgeführt hat und Google diese möglichst schnell berücksichtigen soll.

Der neue robots.txt-Report ersetzt den robots.txt-Tester, der eingestellt wird.

SEO-Newsletter bestellen

Verwandte Beiträge

Neue Auffälligkeiten Google Search Console: Greifen SEO-Crawler und KI-Bots wieder auf Suchergebnisse zu?