Google hat die Spracherkennung für seine Apps optimiert. Daraus ergeben sich eine zuverlässigere Zuordnung von Lauten und Worten, eine erhöhte Geräuschtoleranz und kürzere Berechnungszeiten.

Google hat die Spracherkennung für seine Apps optimiert. Daraus ergeben sich eine zuverlässigere Zuordnung von Lauten und Worten, eine erhöhte Geräuschtoleranz und kürzere Berechnungszeiten.

Die Suche per Sprache liegt im Trend. Statt umständlicher Eingaben der Suchbegriffe auf einer kleinen Tastatur lassen sich auch längere Abfragen einfach per Mikrofon an die Suchmaschinen übergeben. Google bietet die sprachbasierte Suche per "Ok Google" in verschiedenen Apps an, und auch verschiedene digitale Assistenten wie Microsofts Cortana oder Apples Siri nutzen Technologien zur Spracherkennung.

Neue Art von Neuronalen Netzen

Google ist es jetzt gelungen, diese Spracherkennung deutlich zu verbessern und effizienter zu machen. Statt des bisher eingesetzten Deep Neural Networks, also ein Neuronales Netz mit verschiedenen Ebenen, kommt eine Technik mit dem Namen Connectionist Temporal Classification (PDF) in Verbindung mit sequenzunterscheidenden Trainingsmethoden zum Einsatz. Dabei handelt es sich um eine besondere Form der Rekurrenten Neuronalen Netze, die in ihrer Struktur und Verknüpfung stärker an die Verschaltung im Gehirn angelehnt sind.

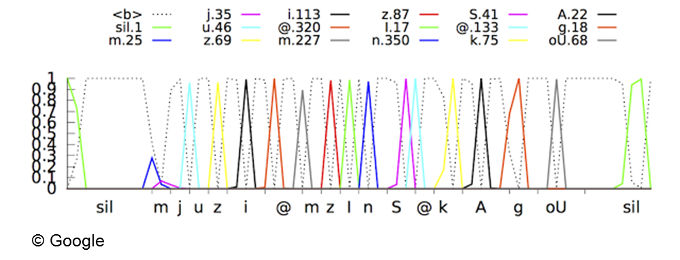

Bei der klassischen Spracherkennung wird die gesprochene Wellenform in kleine, aufeinanderfolgende Abschnitte von etwa zehn Millisekunden zerlegt und danach jeder sich daraus ergebende Feature-Vektor durch ein ein akustisches Modell geschickt, das eine Wahrscheinlichkeitsaussage über verschiedene Phoneme (Laute) trifft. Diese Informationen werden dann mit weiteren Informationen wie zum Beispiel einem Aussprachemodell verbunden, das den Lauten Worte zuordnet. Schließlich kommt noch ein Sprachmodell zur Anwendung, um die Worte in sinnvolle Sequenzen (Sätze) zu bringen.

Das Rekurrente Neuronale Netz, das jetzt bei der Google-Spracherkennung zum Einsatz kommt, sieht Feedbackschleifen vor, die das Abbilden von zeitlichen Abhängigleiten erlauben. Das hilft vor allem bei der Erkennung von ähnlichen Lauten, die zuvor schwierig auseinanderzuhalten waren - etwa dann, wenn mehrere Buchstaben zu einem Laut zusammengefasst werden. Google verwendet ein Long Short-Term-Speicher- (LSTM-)RNN, das Informationen noch besser speichern kann als herkömmliche RNNs.

Als weitere Verbesserung wurde damit experimentiert, die Audioströme in größeren Blöcken zu verarbeiten und dafür die Zahl der Berechnungsrunden zu reduzieren. Dadurch konnte die Erkennung deutlich beschleunigt werden, während gleichzeitig die Gesamtrechendauer sank.

Zunächst werden die Google-Apps für iOS und Android sowie die Spracheingabe auf Android-Geräten von den neuen Sprachmodellen profitieren. Ob die Änderungen zunächst nur für die englische oder für alle von Google unterstützten Sprachen gelten, teilt Google nicht mit.