Google-Updates: warum Qualität immer wichtiger wird

Spätestens seit Panda Teil des Google-Cores ist und Google regelmäßig Qualitäts-Updates durchführt, befinden sich Webseiten mit minderwertigen Inhalten oder einer schlechten Usability auf der Verliererstraße. Das ist zu begrüßen, denn davon profitieren vor allem die Nutzer.

Spätestens seit Panda Teil des Google-Cores ist und Google regelmäßig Qualitäts-Updates durchführt, befinden sich Webseiten mit minderwertigen Inhalten oder einer schlechten Usability auf der Verliererstraße. Das ist zu begrüßen, denn davon profitieren vor allem die Nutzer.

Im letzten Jahr rollte Google ein Update seines Core-Algorithmus aus, dem die SEOs zunächst den Namen "Phantom" gaben, weil es nicht angekündigt war und es auch keine offizielle Bestätigung seitens Google gab.

Wie sich bald zeigen sollte, bezog sich Phantom vor allem auf die Qualität von Webseiten - ähnlich wie die bekannten Panda-Updates, die inzwischen zum Kernalgorithmus Googles gehören.

In der Zwischenzeit gab es immer wieder solche Core- oder Qualitätsupdates, das letzte Mal Anfang September dieses Jahres, als zuerst lokale Rankings und später auch weitere Suchergebnisse betroffen waren.

Bezeichnend für diese Qualitätsupdates ist, dass sie sich offenbar auf die komplette Domain beziehen und nicht pro Seite angewandt werden wie beispielsweise der Mobile-Friendly-Algorithmus. Wenn eine Webseite unterhalb einer gewissen Qualitätsschwelle bleibt, dann kann sich das verheerend auf die komplette Domain auswirken, was zu schlechteren Rankings, weniger Traffic, weniger Rich Snippets etc. führen kann.

Das bedeutet: Zukünftig wird es noch wichtiger sein, auf die Qualität der Inhalte von Webseiten zu achten. Dabei geht es erstens um die Inhalte selbst - beispielsweise sollten diese ausreichend fundiert, nicht zu oberflächlich und auch vom Stil her überzeugend sein. Dazu kommt die Nutzbarkeit bzw. die Usability: Die Webseite sollte so gestaltet sein, dass die Inhalte leicht erreichbar sind. Sie sollte übersichtlich sein und die Nutzer nicht durch übertriebene Werbung, Popups oder andere störende Elemente beeinträchtigen.

Auf Search Engine Land hat Glenn Gabe eine Reihe von Kriterien gezeigt, die zu einer Abwertung durch Googles Core-Algorithmen führen können. Leider kann man im Web viele Beispiele solcher Praktiken finden.

Faktoren, welche die Usability beeinträchtigen

Ein Fehler, den viele Webseiten begehen, besteht in einer unübersichtlichen und vollgestopften Seitenstruktur. Aktuelle Inhalte werden mit Werbung vermischt, die Hauptnavigation ist nicht zu erkennen, und man möchte die Seite am liebsten gleich wieder verlassen.

Das wird noch übertroffen von Seiten, die massiv in die Handlungsmöglichkeiten der Nutzer eingreifen, indem beispielsweise der Zurück-Button des Browsers blockiert wird. Sehr beliebt ist auch das Einblenden eines Popups, wenn man sich mit der Maus dem Zurück-Button oder dem Schließen-Icon des Browsers nähert. Das einzige, was man aber damit erreichen kann, ist, dass der Nutzer das nächste Mal lieber eine andere Seite besucht.

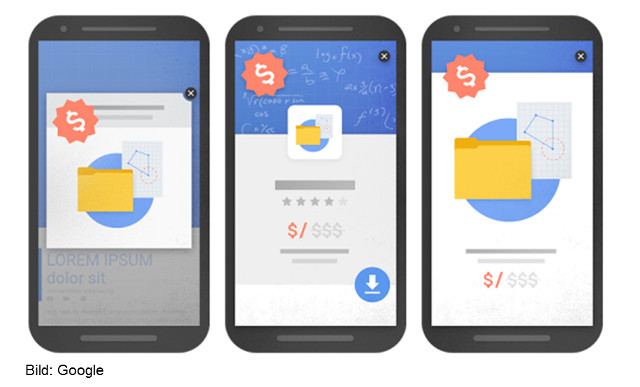

Nicht zu vergessen sind großformatige Anzeigen, durch welche die eigentlichen Inhalte an den Rand oder nach unten verdrängt werden. Ganz zu schweigen von der Darstellung auf Mobilgeräten: Hier nerven solche Banner besonders. Achtung: Google prüft die Menge an Werbung im oberen Seitenbereich ("Above the Fold"). Ist dieser Bereich zu sehr durch Werbung belegt, sieht es mit der Bewertung der Qualität schlecht aus.

Doch das ist noch nicht die Spitze: Möchte man Google so richtig ärgern, dann muss man dafür sorgen, dass die Inhalte der Seite vom Googlebot nicht gerendert werden können. Eine Ursache dafür kann der unsachgemäße Gebrauch von Popups sein.

Es sollte klar sein, dass spätestens mit Googles Ankündigung, Webseiten mit sogenannten Interstitials abzuwerten, der Einsatz von Popups überdacht werden sollte.

Werbung kann auch irreführend sein - das ist dann der Fall, wenn sie nicht als solche gekennzeichnet ist. Viele Webseitenbetreiber bauen Werbung "nahtlos" in die Inhalte ein, um die Klickrate der Anzeigen zu erhöhen. Für die Nutzer ist das äußerst ärgerlich, denn sie finden sich auf Seiten wieder, die sie gar nicht aufrufen wollten.

Auch sehr schlimm: Es gibt auf vielen Webseiten den Trend, selbst kleine Artikel auf mehrere Seiten zu verteilen, um damit die Zahl der Page Impressions und damit auch die Zahl der Werbeeinblendungen zu erhöhen. Das kann so weit gehen wie in einem Fall, in dem ein Artikel auf 38 Seiten aufgeteilt war. Jede Seite enthielt genau einen Absatz. Würde man eine solche Webseite nochmals besuchen wollen?

Schlechte Inhalte

Über die Qualität von Webseiteninhalten wurde in der Vergangenheit schon viel geschrieben. Oft ist die Rede von sogenanntem "Thin Content". Das heißt nicht mehr, als dass nur eine oberflächliche Behandlung eines Themas geliefert wird. Für die Nutzer sind solche Seiten eine Zumutung: Man ist auf der Suche nach Informationen zu einem Thema, und eine gut rankende Seite liefert nur einen einzigen Absatz und ansonsten nur Werbung und Links zu nicht relevanten Beiträgen. Der einzige Zweck solcher Seiten besteht darin, Nutzer auf die Seite zu holen und mit Werbung Geld zu verdienen. Zu Recht bestraft Googles Panda-Algorithmus solche Seiten mit schlechteren Rankings.

Viele Webseiten versuchen, die Nutzer zu halten, indem neben dem eigentlichen Beitrag Empfehlungen zu weiteren Artikeln und Themen angezeigt werden. Wenn das jedoch dazu führt, dass eine Seite fast nur noch aus Links auf wenig oder nicht relevante, möglichst schon alte und nicht mehr aktuelle Themen besteht, wird man als Nutzer schnell die Lust verlieren, sich länger auf der Seite aufzuhalten.

Was kann man tun, um die Qualität einer Webseite zu steigern?

Man sollte nicht erst warten, bis man Opfer eines der nächsten Google-Updates wird. Schon jetzt sollte überprüft werden, ob Inhalte und Usability der Seite passen. Dazu kann man eine Reihe von Checks durchführen:

Andere Personen bitten, sich die Seite anzusehen: Idealerweise sollten diese Personen sich mit dem Thema der Seite nicht gut auskennen und die dort enthaltenen Inhalte trotzdem verstehen. Danach sollte man die Personen fragen, ob sie sich auf der Seite zurecht gefunden haben. Sind alle Navigationselemente auf den ersten Blick sichtbar (zum Beispiel das Hauptmenü, die Suche etc.)?

Die Webseite crawlen: Mit passenden Werkzeugen wie zum Beispiel Screaming Frog kann man eine Seite komplett crawlen und sich Listen der wichtigsten Seiteninhalte wie Titel, Description, Überschriften etc, anzeigen lassen. Damit lassen sich schnell grobe Qualitätsprobleme erkennen.

Falls es bereits zu einem Verlust von Rankings gekommen ist, sollte man einen Blick auf die Landing Pages werfen, die besonders betroffen sind. Sind die Inhalte noch aktuell? Sind sie ausführlich genug? Was könnte die Nutzer stören?

Abruf wie durch Google: Mit diesem Werkzeug kann man überprüfen, wie der Googlebot eine Webseite sieht. Diese Sicht sollte derjenigen für die Nutzer im Browser entsprechen.

Interstitials, störende Popups, überschüssige Werbung oder irreführende Navigationselemente sollten entfernt werden. Sie beeinträchtigen nicht nur die Nutzbarkeit, sondern können auch verhindern, dass eine Seite richtig gecrawlt wird. Nicht zuletzt beeinträchtigen sie das Verhältnis von Inhalten zu Werbung und können somit den von Google beigemessenen Qualitätswert mindern.

Titelbild © Felix Pergande - Fotolia.com

Verwandte Beiträge

Google Discover Core Update vom Februar ist beendet