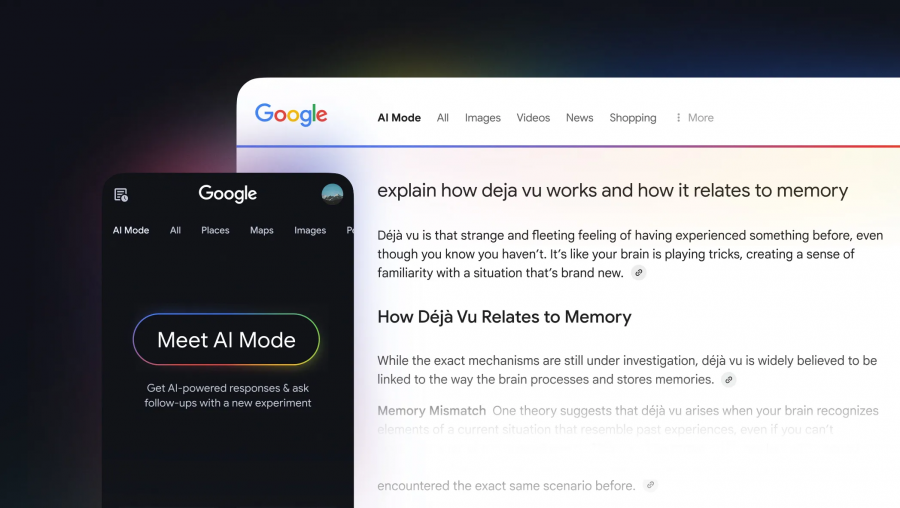

Google Gemini: Personal Intelligence verbindet Daten aus Suche, Mail und mehr

Mit ‘Personal Intelligence’ wird Google Gemini persönlicher, weil Daten aus der Suche, E-Mails, Fotos und mehr für die KI genutzt werden.

SEO-Beratung: Wir sind Ihre Experten

Wir bringen gemeinsam Ihre Webseite in Google nach vorne. Profitieren Sie von jahrelanger SEO-Erfahrung.

Google wehrt sich gegen Vorwürfe zu überzogenen Preisen beim KI-Shopping per UCP

Google widerspricht Vorwürfen, dass KI-Shopping und das UCP-Protokoll zu überzogenen Preisen führen können.

SEO-Auswertungen: KI-Agent Manus integriert jetzt Daten aus Similarweb

Der KI-Assistent Manus bietet jetzt die Möglichkeit, SEO-Kennzahlen wie zum Beispiel aktuelle Rankings aus Similarweb zu integrieren.

Claude Cowork ist da: persönlicher KI-Assistent organisiert Dateien

Anthropic hat Claude Cowork vorgestellt, einen persönlichen KI-Assistenten, der Dateien organisieren und andere Aufgaben übernehmen kann. Gleichzeitig warnt Anthropic vor möglichen Gefahren.

Apple-Deal: Google sichert sich mit Gemini Vorherrschaft auch im KI-Bereich

Apple wird seine KI-Modelle zukünftig auf Google Gemini aufbauen. Der Deal dürfte Google auch im Bereich der KI-Suche die Vorherrschaft sichern.

KI-Shopping: Google stellt Universal Commerce Protocol (UCP) vor

Google hat mit UCP einen offenen Standard für Agentic Commerce vorgestellt. Neu ist auch der Business Agent, der eine direkte Kommunikation in der Suche mit Marken ermöglicht.

Google nutzt Core Search Signals auch für KI-Antworten

Google verwendet bei der Auswahl von Quellen für die KI-Antworten die wichtigsten Signale aus der Suche. Das hat jetzt Robby Stein, Vice President Search bei Google, in einem Interview bestätigt.

Google: Empfehlungen für KI-Optimierungen können morgen schon überholt sein

In einer neuen Ausgabe des Google SEO Podcasts 'Search Off the Record' sprechen John Müller und Danny Sullivan über die Optimierung für KI und warnen davor, jedem technischen Trend zu schnell zu folgen. Dafür sei die Geschwindigkeit der Entwicklung zu hoch. Was weiter im Mittelpunkt stehen sollte, ist die Fokussierung auf die Nutzer.

Google: John Müller empfiehlt, die KI-Leistung von Websites mit den richtigen Kennzahlen zu überwachen

Die Leistung einer Website in KI-Systemen sollte laut John Müller von Google anhand der richtigen Kennzahlen überwacht werden. KI werde bleiben.

ChatGPT Health ist da: persönlicher KI-Gesundheitsassistent

OpenAI bringt mit ChatGPT Health einen persönlichen Gesundheitsassistenten, der allerdings einigen Einschränkungen unterliegt. So können Nutzer in den meisten europäischen Ländern vorerst nicht teilnehmen.

Weitere Beiträge

- LLMs: Brauchen wir Retrieval Augmented Generation (RAG) noch?

- Google Search Console: neuer Filter für marken- und nicht markenbezogene Suchanfragen

- Die Zukunft der Suche: Robbie Stein von Google gibt einen Ausblick

- Gericht: Perplexity Comet Browser darf nicht mehr auf Amazon-Konten zugreifen

- KI-Tools: Google Gemini im Jahresvergleich 17mal stärker gewachsen als ChatGPT

- Google: Suchvolumen wächst wegen KI, Kennzeichnung von Bezahlinhalten möglich

- ChatGPT zeigt seit GPT-5.3 keine Query-Fanouts mehr an - doch es gibt eine Alternative

- GEO und die doppelte Korrelations-Falle

- Google AI Overviews: deutlich mehr Links seit Gemini 3 - neue Studie

- Google AI Mode zeigt jetzt mehr Links auf Rezept-Websites an

- Status Quo: Die aktuelle Lage der SEO

- Neue Studie zeigt: Vor allem junge Nutzer bevorzugen Google

- KI-Halluzinationen eröffnen Chancen für Broken Link Building und neuen Content

- Google Patent zur KI-generierten Webseitenerstellung: bald nichts mehr zu tun für SEOs und Webdesigner?

- Wo die Klicks wirklich bleiben: Google AI Overviews sind nur ein Teil des Problems

- Google Discover: Das sind die Veränderungen durch das Core Update vom Februar

- Google erklärt, ob korrektes HTML heute noch für SEO wichtig ist

- Google Discover Core Update vom Februar ist beendet

- Google Nano Banana 2 ist da: Bild-KI mit Highspeed

- Google plant laut Bericht Änderungen an den Suchergebnissen in Europa